Was ist High Performance Computing (HPC)?

HPC (zu Deutsch: Hochleistungsdatenverarbeitung) bezeichnet die Implementierung von Supercomputern und Computerclustern, um komplexe Rechenprobleme mit enormer Geschwindigkeit zu lösen. Diese Technologie nutzt die Leistung mehrerer parallel arbeitender Prozessoren zur Verarbeitung umfangreicher Datensätze und ist dabei oft über eine Million Mal schneller als herkömmliche Desktop- oder Serversystemen.

Diese Hochleistungssysteme können Billionen von Rechenoperationen pro Sekunde durchführen und übersteigen die Fähigkeiten eines klassischen Desktop-Computers oder einer Workstation damit bei Weitem. Sie werden häufig eingesetzt, um große Probleme in Wissenschaft, Technik und Wirtschaft in Angriff zu nehmen. Typische Beispiele sind hier die numerische Strömungsmechanik, das Data Warehousing, die Transaktionsverarbeitung sowie das Schaffen und Testen virtueller Prototypen.

Warum ist HPC so wichtig?

Hochleistungsrechensysteme sind aus mehreren Gründen unerlässlich. Erstens ermöglichen sie die Verarbeitung riesiger Datenmengen und komplexe Berechnungen mit phänomenaler Geschwindigkeit, was in der informationsgetriebenen Welt von heute eine entscheidende Rolle spielt. Diese hohe Geschwindigkeit ist für Echtzeitanforderungen wie die Nachverfolgung entstehender Stürme, das Testen neuer Produkte oder die Analyse von Aktientrends absolut erforderlich.

Auch die wissenschaftlicher Forschung, künstliche Intelligenz und Deep Learning können damit vorangetrieben werden. Tatsächlich haben diese Systeme den wissenschaftlichen und technischen Fortschritt in den USA deutlich beschleunigt und zu Fortschritten bei der Klimamodellierung, modernen Fertigungstechniken und der nationalen Sicherheit beigetragen.

Diese zentrale Bedeutung macht sich in diversen Branchen bemerkbar (z. B. im Gesundheitswesen, in der Luftfahrt und in der Fertigungsindustrie), wo die Bewältigung komplexer Workloads und die Datenverarbeitung nahezu in Echtzeit ermöglicht wird. HPC-gestütztes Simulieren kann die Notwendigkeit physischer Tests generell reduzieren oder sogar eliminieren, wodurch Zeit und Ressourcen gespart werden.

Wie funktioniert HPC?

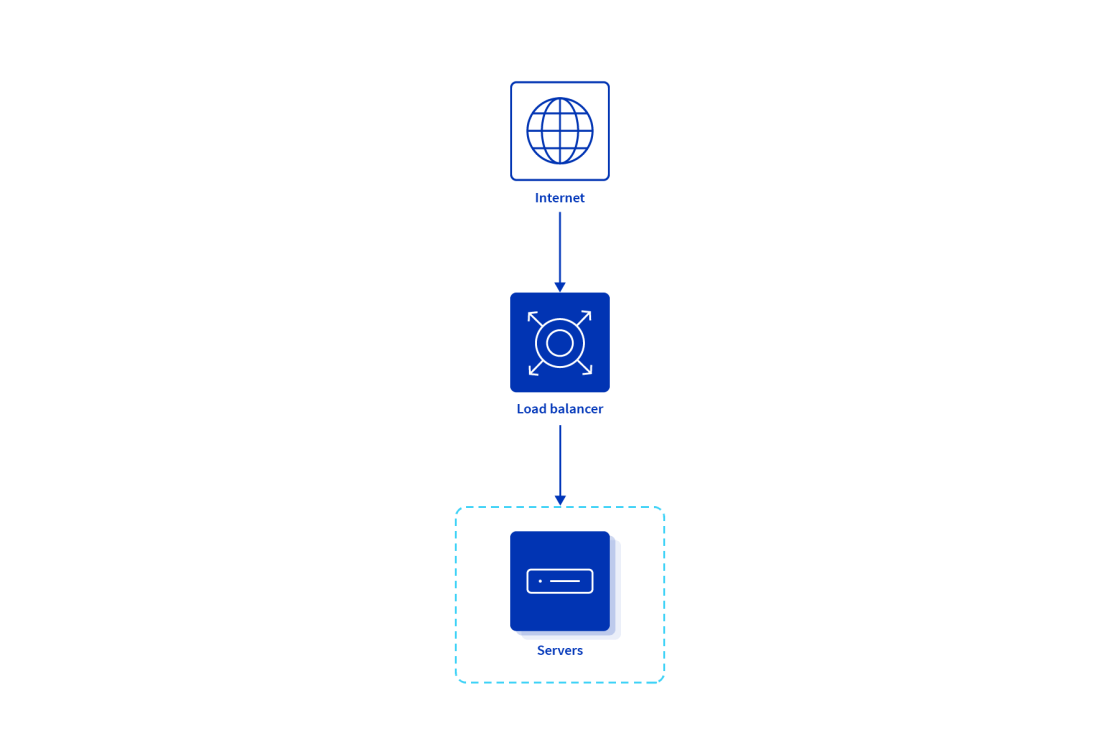

HPC-Systeme bestehen in der Regel aus Hunderten oder Tausenden von Compute-Servern, auch Nodes genannt, die zu einem Cluster zusammengeschaltet werden. Dies wird auch als Parallelverarbeitung oder Parallel Processing bezeichnet, wo mehrere Tasks gleichzeitig über Nodes hinweg ausgeführt werden.

Damit maximale Leistung erreicht wird, muss jede Komponente des Systems, einschließlich der Speicher- und Netzwerkkomponenten, mit den anderen Schritt halten. So muss zum Beispiel die Speicherkomponente imstande sein, Daten so schnell in die Compute-Server einzuspeisen und von diesen aufzunehmen, wie sie verarbeitet werden. Wenn eine Komponente nicht mit dem Rest mithalten kann, leidet die Leistung der gesamten Infrastruktur.

HPC im Cloud Computing

Im Cloud Computing kombiniert HPC die Rechenleistung und Skalierbarkeit der traditionellen Hochleistungsdatenverarbeitung mit der Flexibilität und den On-Demand-Ressourcen von Cloud-Diensten.

In einer Cloud-Umgebung können User auf umfangreiche Computing-Ressourcen wie Prozessorleistung, Arbeitsspeicher und Storage zugreifen und diese nutzen, um komplexe und ressourcenintensive Aufgaben zu bewältigen. Diese Aufgaben umfassen Simulationen, wissenschaftliche Forschung, Datenanalysen sowie andere rechenintensive Workloads mit erheblichem Ressourcenbedarf.

Für eine effiziente Kommunikation zwischen den Nodes erfordern HPC-Workloads niedrige Latenzzeiten sowie Netzwerke mit großer Bandbreite. Cloud Provider bieten hier schnelle Verbindungsoptionen, um diese Kommunikation zu unterstützen. Eine effiziente Datenübertragung ist ebenfalls entscheidend, und Cloud-Plattformen bieten Tools und Lösungen zum sicheren Übertragen großer Datensätze in die und aus der Cloud.

Zu den Vorteilen des Einsatzes Cloud-basierter Hochleistungssysteme gehören deren Skalierbarkeit, die es den Usern ermöglicht, ihre Rechenressourcen nach Bedarf zu skalieren, sowie die Kosteneffizienz, da User bei Cloud-basierten Modellen nur für die Ressourcen zahlen, die sie auch tatsächlich nutzen, und somit nicht in teure On-Premise-Infrastruktur investieren oder diese warten müssen.

Was ist ein HPC-Cluster?

Ein Cluster für die Hochleistungsdatenverarbeitung besteht aus mehreren miteinander verbundenen Servern, die als Nodes bezeichnet werden und zusammenarbeiten, um komplexe Rechenaufgaben mit phänomenaler Geschwindigkeit auszuführen.

Diese Cluster sind auf die Verarbeitung großer Datenmengen ausgelegt und über eine schnelle Verbindung miteinander verbunden, damit sie effizient kommunizieren und Informationen verarbeiten können. Die Nodes innerhalb eines Clusters können zum Ausführen verschiedener Aufgaben spezialisiert sein und enthalten in der Regel Komponenten ähnlich denen normaler Computer – z. B. CPU-Kerne, Arbeitsspeicher und Storage –, die jedoch eine größere Kapazität, Qualität und Leistung bieten.

Login-Nodes

Login-Nodes fungieren als Gateway für den Zugriff der User auf den Cluster. Sie sind für Aufgaben wie die Vorbereitung von Übergabeskripten für Batch-Arbeiten, die Übermittlung und das Monitoring von Jobs, die Analyse von Ergebnissen sowie die Datenübertragung zuständig. Diese Nodes sind nicht dazu vorgesehen, Rechenaufgaben auszuführen oder Software zu kompilieren, was stattdessen von Compute-Nodes oder gegebenenfalls durch eine interaktive Sitzung erfolgen sollte.

Compute-Nodes

Compute-Nodes sind die Arbeitstiere eines Clusters, die die meisten numerischen Berechnungen durchführen. Sie verfügen nur über einen geringen persistenten Speicher, sind jedoch mit einem großen DRAM-Arbeitsspeicher ausgestattet, um die Rechenlast zu bewältigen. Diese Nodes führen Workloads mithilfe lokaler Ressourcen wie CPUs und in einigen Fällen GPUs aus.

Large-Memory-Nodes

Large-Memory-Nodes sind spezialisierte Nodes innerhalb eines Clusters, die über eine wesentlich größere Arbeitsspeicherkapazität verfügen als reguläre Compute-Nodes. Sie sind für Jobs mit größerem RAM-Bedarf konzipiert und unerlässlich, wenn der Arbeitsspeicher normaler Nodes schlicht nicht ausreicht. Daher werden Jobs, die mehr Arbeitsspeicher benötigen, als auf Standard-Nodes verfügbar ist, in der Regel auf diesen Large-Memory-Nodes ausgeführt.

GPU-Nodes

GPU-Nodes sind zusätzlich zu den CPU-Cores mit grafischen Processing Units (GPUs) ausgestattet. Diese Nodes sind für Berechnungen optimiert, die parallel auf einer GPU ausgeführt werden können. Dadurch können bestimmte Vorgänge erheblich beschleunigt werden, insbesondere solche, die für die Architektur von GPUs geeignet sind.

Reservierte oder spezialisierte Nodes

Reservierte oder spezialisierte Nodes sind Nodes innerhalb eines Clusters, die für bestimmte Aufgaben konfiguriert oder bestimmte User oder Gruppen reserviert sind. Diese Nodes können Beschleuniger oder andere spezialisierte Hardware umfassen, um bestimmte Rechenanforderungen zu erfüllen oder Workloads zu bewältigen, die spezielle Ressourcen erfordern, welche in den Standard-Compute-Nodes nicht vorhanden sind.

Uses Cases für HPC

High Performance Computing ist nur bei bestimmten Anforderungen optimal geeignet. Eine der größten Herausforderungen sind die damit verbundenen Kosten. Bei der Hochleistungsdatenverarbeitung können zwar enorme Datenmengen schnell verarbeitet werden, dafür ist sie aber für Aufgaben, die keine derartigen Geschwindigkeiten oder Datenvolumen erfordern, möglicherweise weniger sinnvoll. Dennoch ist die Hochleistungsdatenverarbeitung in vielen Umgebungen von entscheidender Bedeutung, denn ohne sie wären manche Tasks einfach nicht zu bewältigen.

Optimale Use Cases des HPC

HPC ist für eine Vielzahl von Anforderungen in verschiedenen Branchen und Wissenschaftsfeldern optimal geeignet. Hier einige konkrete Beispiele:

- Gesundheitswesen und Biowissenschaften: Die Hochleistungsdatenverarbeitung wird eingesetzt, um Daten für Diagnosen, klinische Studien oder unmittelbare medizinische Eingriffe nahezu in Echtzeit zu verarbeiten. Darüber hinaus wird sie zum Untersuchen von Biomolekülen und Proteinen in menschlichen Zellen verwendet, um neue Medikamente und medizinische Therapien zu entwickeln. Auch im Hinblick auf die Modellierung und Simulation des menschlichen Gehirns ist die Hochleistungsdatenverarbeitung unerlässlich.

- Luft- und Raumfahrt und Fertigungsindustrie: Hier sind High-Performance-Systeme hervorragend zum Optimieren der in der Fertigung verwendeten Materialien geeignet. Dank datenverarbeitungsgestützter Forschung sind Unternehmen in der Lage, mit einem möglichst geringen Materialaufwand widerstandsfähigere Komponenten zu entwickeln. Außerdem kommt HPC zum Einsatz, um Produktionsstraßen zu simulieren und Abläufe besser zu verstehen und damit die Effizienz insgesamt zu steigern.

- Energie und Umwelt: Die Hochleistungsdatenverarbeitung wird in der Klimaforschung verwendet, einschließlich der Modellierung und Simulation von Klimamustern. Es wird auch zum Entwickeln einer nachhaltigen Landwirtschaft und zum Analysieren von Nachhaltigkeitsfaktoren eingesetzt. Zudem spielt es eine entscheidende Rolle bei der Erforschung der Kernenergie, der Kernfusion, der erneuerbaren Energien und des Weltalls.

- AI und Machine Learning: HPC kann auch andere Verarbeitungsformen unterstützen und zum Beispiel für den Betrieb groß angelegter AI-Modelle in Bereichen wie der kosmischen Theorie, Astrophysik, Physik und zur Verwaltung unstrukturierter Datensätze verwendet werden.

Dies sind nur einige Beispiele. Weitere Beispiele umfassen Finanzdienstleistungen, bei denen die Hochleistungsdatenverarbeitung für Analysen zur Bewertung finanzieller Risiken und zur Vorhersage von Markttrends verwendet wird, während Medien- und Unterhaltungsunternehmen HPC für das Rendering sowie die Audio- und Videoverarbeitung in der Medienproduktion nutzen. Selbst in staatlichen Behörden kann das High Performance Computing überzeugen, z. B. bei der Analyse von Volkszählungs- und IoT-Daten (Internet of Things) sowie der Unterstützung groß angelegter Infrastrukturprojekte.

Weniger geeignete Use Cases für die Hochleistungsdatenverarbeitung

High Performance Computing ist nicht für jedes Problem die ideale Lösung. Im Folgenden finden Sie einige Beispiele, für die Alternativen möglicherweise besser geeignet sind:

Verarbeitung sensibler Daten

Obwohl HPC große Datenmengen schnell verarbeiten kann, ist es möglicherweise nicht die beste Wahl für die Handhabung vertraulicher Informationen. Die Datenspeicherung im Shared- und Batch-Modus stellt eine Herausforderung im Umgang mit vertraulichen Daten wie Gesundheits-, Finanz- oder personenbezogenen Informationen dar.

Es gibt zwar Methoden, um vertrauliche Informationen in diesen Systemen sicher zu verarbeiten, diese erfordern jedoch häufig zusätzliche Maßnahmen und können vorhandene Abläufe beeinträchtigen.

Weniger umfangreiche Workloads

HPC-Systeme sind für die Verarbeitung großer Datenmengen und komplexer Berechnungen konzipiert. Was weniger umfangreiche Workloads betrifft, ist der Zeit- und Arbeitsaufwand für das Training zur Verwendung von Clustern sowie deren eigentliche Verwaltung möglicherweise nicht gerechtfertigt.

Die Investitionen in Schulungen zu Linux, Shell Scripting und anderen Kompetenzen zur Verwendung von HPC-Clustern können bei geringem Arbeitsvolumen anderweitig sinnvoller eingesetzt werden.

Kleinere serielle Workloads mit geringem RAM-Bedarf

Die Hochleistungsdatenverarbeitung ist kein Wundermittel, mit dem jeder Workload automatisch schneller läuft. Workflows, die nur auf einem einzelnen Kern (d. h. seriell) ausgeführt werden und keine große Arbeitsspeicherkapazität erfordern, werden bei der Hochleistungsdatenverarbeitung wahrscheinlich langsamer abgeschlossen als auf den meisten modernen Desktop-Computern und Laptops.

Wenn Sie eine kleinere Anzahl von seriellen Jobs verarbeiten, werden Sie bestimmt feststellen, dass Ihr Computer diese schneller erledigt hätte.

Schulungs- und Bildungszwecke

An Universitäten dienen HPC-Cluster der Bewältigung großer Rechenlasten und werden in der Regel nicht als Trainingshilfe oder Lehrmittel eingesetzt.

Auch wenn es für Schulungen rund um High Performance Computing Ausnahmen geben kann, die speziell für das zuständige Personal stattfinden, werden diese Systeme normalerweise nicht für allgemeine Schulungs- oder Ausbildungszwecke genutzt.

Unrechtmäßige oder nicht forschungsbezogene Zwecke

HPC-Cluster werden bereitgestellt, um legitime Forschungsarbeit zu unterstützen. Eine unsachgemäße Nutzung von Cluster-Ressourcen, wie z. B. das Mining von Kryptowährungen, das Hosten von Webdiensten, die missbräuchliche Nutzung von File Storage für persönliche Dateien, der Zugriff auf Dateien oder Software ohne die entsprechenden Berechtigungen oder eine andere unrechtmäßige Nutzung wird wahrscheinlich zu einer Untersuchung und entsprechenden Maßnahmen führen.

Auch eine gemeinsame Account-Nutzung ist nicht gestattet, und User/Parteien, die bei der gemeinsamen Verwendung eines Accounts ertappt werden, müssen ebenfalls mit Ermittlungen und rechtlichen Konsequenzen rechnen.

Innovationen bei HPC

Im High Performance Computing gab es in den letzten Jahren mehrere bedeutende Innovationen. Es werden immer mehr Cloud-basierte Lösungen eingesetzt, die skalierbare und kosteneffizient Ressourcen für rechenintensive Aufgaben liefern. Diese Tendenz trägt zur weiteren Verbreitung der Hochleistungsdatenverarbeitung bei und macht diese leistungsstarken Tools einem größeren Nutzerkreis zugänglich.

Die nächste Stufe der Hochleistungsdatenverarbeitung ist das Exascale Computing, das dazu in der Lage ist, ein Exaflop – d. h. eine Trillion Rechenoperationen pro Sekunde – durchzuführen.

Obwohl Quantencomputing sich noch im Anfangsstadium seiner Entwicklung befindet, verspricht es, die Leistung im Vergleich zu herkömmlichen Computern um einige Größenordnungen zu erhöhen. Quantencomputer könnten Probleme lösen, die für klassische Computer aktuell unlösbar sind, und damit neue Möglichkeiten für HPC-Anwendungen eröffnen.

HPC in verschiedenen Branchen

Wie sieht High Performance Computing in der Praxis aus? In diesem Abschnitt beleuchten wir einige praktische Beispiele aus verschiedenen Bereichen.

Branchen mit hohen Anforderungen

High Performance Computing spielt überall dort eine wichtige Rolle, wo eine hohe Rechenkapazität benötigt wird – von den Medizin- und Biowissenschaften bis hin zu den Bereichen Fertigung, Energie und Wettervorhersage. Es beinhaltet den Einsatz leistungsstarker Prozessoren, Server und Systeme, um größere Datensätze zu verarbeiten, komplexe Rechenoperationen durchzuführen und datenintensive Aufgaben effizienter zu erledigen.

Fertigungsindustrie

Im Fertigungssektor wird die Hochleistungsdatenverarbeitung bei einer Vielzahl von Anwendungen zur Problemlösung eingesetzt. Sie hilft älteren Sektoren, sich weiterzuentwickeln, und optimiert Prozesse in moderneren Bereichen wie der additiven Fertigung. Die Hochleistungsdatenverarbeitung hat bereits ihre Fähigkeit unter Beweis gestellt, Herstellungskosten zu reduzieren und die Produktion zu verbessern.

Medien und Unterhaltung

In der Medien- und Unterhaltungsbranche wird HPC zum effizienten Erstellen und Bereitstellen von Content eingesetzt. Es ist für die Erzeugung hochwertiger visueller Effekte und computergenerierter Bilder inzwischen unerlässlich. HPC-Tools müssen mit vorhandenen Tools und Anwendungen integriert werden, um in allen Phasen der Medien-Workflows für Effizienz zu sorgen.

Energiesektor

Obwohl für den Einsatz der Hochleistungsdatenverarbeitung im Energiesektor weniger konkrete Informationen vorhanden sind, ist dennoch bekannt, dass sie in dieser Branche für Aufgaben wie die Modellierung und Simulation von Energiereserven, die Optimierung der Stromnetzverteilung sowie die Verbesserung der Energieeffizienz in Produktionsprozessen weit verbreitet ist.

Gesundheitswesen und Biowissenschaften

Die Hochleistungsdatenverarbeitung revolutioniert die Medizin- und Biowissenschaften, indem Fachleute dazu befähigt werden, Informationen nahezu in Echtzeit zu verarbeiten und Erkenntnisse zu gewinnen, die Behandlungsergebnisse verbessern können. Es unterstützt wissenschaftliche Bereiche von der Forschung bis hin zu industriellen Anwendungen im medizinischen Bereich und ermöglicht es Forscher:innen, schnellere und komplexere Rechenoperationen, Simulationen und Analysen durchzuführen.

Wettervorhersage

HPC ist ein wichtiger Aspekt bei Wettervorhersagen und wird zur Verarbeitung großer Mengen meteorologischer Daten verwendet. Diese werden in komplexe Simulationen und Modelle eingespeist, um Wettermuster und -ereignisse vorherzusagen. Die enorme Geschwindigkeit und Rechenleistung ermöglichen die Erstellung schneller und genauer Prognosen, die wertvolle Informationen für die Planung und Entscheidungsfindung in verschiedenen Bereichen liefern, darunter Landwirtschaft, Energie und Katastrophenmanagement.

Erste Schritte mit HPC

Beginnen Sie Ihr HPC-Projekt mit der Bewertung Ihrer vorhandenen Infrastruktur und legen Sie klare Ziele, Anforderungen, Einschränkungen sowie Ihre Erwartungen fest.

Hierzu gehört auch ein genaues Verständnis der Computing-Anforderungen der Organisation sowie der Workload-Typen, die auf dem System ausgeführt werden sollen. Sobald die Ziele und Anforderungen feststehen, besteht der nächste Schritt in der Auswahl des richtigen Cloud-Anbieters und der geeigneten Tools für die High-Performance-Computing-Anforderungen des Unternehmens. Achten Sie auf skalierbare Ressourcen und spezialisierte Dienste, die auf HPC-Workloads zugeschnitten sind.

Außerdem ist es wichtig, die Führungskräfte in den Entscheidungsprozess einzubeziehen, um eine Übereinstimmung mit der strategischen Ausrichtung des Unternehmens zu gewährleisten und die notwendigen Investitionen zu sichern. Darüber hinaus sollten Unternehmen Best Practices zur Ausführung von Workloads berücksichtigen und unter anderem eine Überlastung des Systems durch zu viele Jobs vermeiden, eine effiziente Nutzung des Speicherplatzes sicherstellen und sich um die nötigen Code-Optimierungen kümmern.

HPC-Lösungen entdecken

Das OVHcloud Angebot umfasst High-Performance-Computing-Lösungen mit schnellen und effizienten Rechenkapazitäten, die ganz ohne Vorlaufkosten bereitgestellt werden. Unser weltweites Netzwerk umfasst 46 Rechenzentren und 44 redundante PoPs in 140 Ländern und gewährleistet so eine niedrige Latenz und die schnelle Bereitstellung von HPC-Kapazität, wenn diese benötigt wird. Kundenanforderungen rund um Machine Learning und die fortschrittliche Datenverarbeitung werden damit stets abgedeckt.

Es steht eine breite Palette an HPC-Lösungen zur Auswahl, einschließlich innovativer Hardware, die von einem speziellen Team für Dedicated-Server-Innovationen gewartet wird, sowie spezialisierte Cloud-GPU-Server für intensive Anwendungen wie die künstliche Intelligenz.

OVHcloud Lösungen sind auf die verschiedensten Anforderungen zugeschnitten und eignen sich unter anderem für Video on Demand, Live Streaming, interaktives Gaming, modernes Simulieren, die Prüfung von Finanzmodellen oder die Analyse umfangreicher Datensätze. OVHcloud bietet Ihnen die Flexibilität, HPC genau dann einzusetzen, wenn Sie es brauchen, ohne dass Sie dafür eine eigene Infrastruktur besitzen müssen.

OVHcloud und High Performance Computing (HPC)

Den besten Dedicated Server für Ihre Business-Anwendungen finden

Mit OVHcloud können Sie sich auf unser Know-how in Sachen Bare-Metal-Technologie verlassen. Hosten Sie Ihre Website, bauen Sie Ihre hochresiliente Infrastruktur auf oder passen Sie Ihre Maschine für Ihre Projekte an – es braucht nur ein paar Klicks.

Ihr privates Rechenzentrum in der Cloud

Beschleunigen Sie Ihre digitale Transformation mit unseren skalierbaren Hosted Private Cloud Angeboten. Unsere Produkte sind flexibel und innovativ und bieten optimale Datensicherheit, sodass Sie sich ganz auf Ihr Geschäft konzentrieren können.

Unsere Netzwerklösungen

Ihre Anwendungen und deren Komponenten müssen das ganze Jahr über rund um die Uhr verfügbar sein? Ob private, öffentliche oder On-Premise-Konnektivität: Unsere Lösungen erfüllen Ihre Netzwerkanforderungen und unsere privaten Netzwerke ermöglichen eine sichere Kommunikation zwischen Ihren Servern und Diensten. OVHcloud betreibt auch ein eigenes Backbone-Netzwerk. Das Backbone von OVHcloud ist für den schnellen und zuverlässigen Zugriff auf Ihre Anwendungen konzipiert – jederzeit und überall. Sie behalten stets die volle Kontrolle über Ihre Daten. Ausnahmslos.