Was ist eine Cloud-GPU?

Eine Cloud-GPU bietet leistungsstarke Grafikverarbeitung über das Internet und bietet schnelles, skalierbares Computing für KI, maschinelles Lernen, Rendering und hochleistungsfähige Arbeitslasten. Sie beseitigt die Notwendigkeit für Hardware vor Ort und unterstützt flexible, bedarfsorientierte Leistung über eine Vielzahl von Aufgaben.

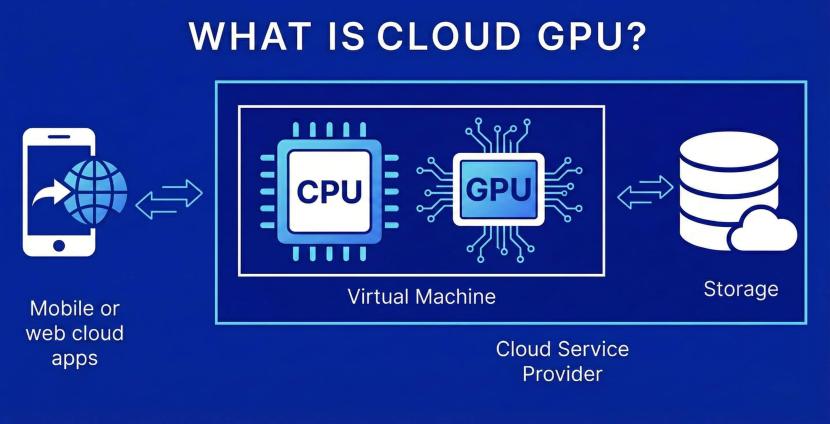

Wie funktioniert eine Cloud-GPU?

Eine Cloud-GPU ist im Wesentlichen ein entfernter Grafikprozessor, der über das Internet verwendet werden kann, um die Leistung für anspruchsvolle Arbeitslasten zu steigern. Anstatt teure Hardware selbst zu kaufen, nutzen Sie einfach einen Anbieter, der Ihnen auf Abruf Zugang zu leistungsstarken GPUs bietet. Es ist eine einfache, kostengünstige Möglichkeit, Ihren Anwendungen — insbesondere schwereren Arbeitslasten wie KI-Modellen, maschinelles Lernen oder 3D-Arbeiten — ernsthafte Rechenleistung zu geben, ohne teure lokale Geräte zu kaufen.

Hinter den Kulissen arbeiten Cloud-GPUs, indem sie etwas verwenden, das GPU-Virtualisierung genannt wird. Dies ermöglicht es dem Cloud-Anbieter, physische GPU-Karten in mehrere sichere, isolierte Teile zu unterteilen, wobei jedes Stück seine eigene "Instanz" wird, mit eigenem Speicher und Rechenleistung. Infolgedessen können Sie die Größe wählen, die zu Ihrer Arbeitslast passt, egal ob Sie im kleinen Maßstab testen oder anspruchsvollere Trainingsaufgaben ausführen und nach Bedarf skalieren.

Die Verwendung einer Cloud-GPU ist unkompliziert. Sie können über APIs, Dashboards oder Automatisierungstools darauf zugreifen, was die Integration in bestehende Pipelines erleichtert. Mit Cloud-GPUs können Sie alle Ihre Aufgaben remote verwalten — von KI-Modellen bis hin zu 3D-Rendering und hochleistungsfähigen Simulationen. Diese Flexibilität ist besonders nützlich, wenn Sie mit verschiedenen Anwendungen experimentieren oder von älteren Umgebungen migrieren.

Ein weiterer Grund, warum Cloud-GPUs besonders praktisch sind, ist, wie einfach sie sich mit anderen Cloud-Computing-Diensten verbinden lassen. Sie können sie mit Online-Speicher, Netzwerktools oder sogar Multi-Cloud-Plattformen verknüpfen, um flexible KI-Infrastrukturen aufzubauen, die sich an Ihre sich ändernden Bedürfnisse anpassen. Viele Teams ziehen diese Option vor, da sie die Kosten und die Komplexität des Kaufs, der Wartung und der Aufrüstung physischer Hardware reduziert. Und im Gegensatz zu lokalen GPUs ersparen Cloud-GPUs Ihnen die Mühe, sich mit Platz, Strom, Kühlung und laufenden Kosten auseinanderzusetzen.

Die wichtigsten Unterschiede verstehen: CPU- vs. GPU-Architektur

CPUs und GPUs verarbeiten beide Daten, sind jedoch für völlig unterschiedliche Ansätze des Rechnens ausgelegt. Eine CPU eignet sich gut für die Verarbeitung einer Vielzahl von allgemeinen Anwendungen und befasst sich oft mit Aufgaben, die sequentielle Logik oder spezifische Anweisungen erfordern. Eine GPU hingegen glänzt, wenn Sie massive parallele Rechenleistung benötigen, und ist ideal für Grafiken, Simulationen, maschinelles Lernen und KI-Modelle, die auf Tausenden von kleinen gleichzeitigen Berechnungen basieren.

Hier ist eine einfache Tabelle, um die architektonischen Unterschiede zu verdeutlichen:

| Funktion | CPU | GPU |

| Kern-Design | Wenige Hochleistungs-Kerne, die für sequenzielle Aufgaben ausgelegt sind | Hunderte oder Tausende von kleineren Kernen, die für parallele Verarbeitung optimiert sind |

| Am besten geeignet für | Allgemeine Anwendungen, Systemmanagement und logikintensive Aufgaben | KI, maschinelles Lernen, Rendering, Simulationen und hochleistungsfähige Arbeitslasten |

| Speicherverwaltung | Niedriglatente Zugriffe für schnelle Entscheidungsfindung | Hochbandbreitenspeicher für große Datensätze und Modelle |

| Verarbeitung | Führt ein oder wenige komplexe Aufgaben gleichzeitig aus | Führt Tausende von leichten Aufgaben gleichzeitig aus |

| Flexibilität | Hochgradig anpassungsfähig für verschiedene Rechenaufgaben | Hocheffizient für sich wiederholende, parallele Aufgaben |

Cloud-GPU vs. physische GPU

Cloud GPU

- Bietet bedarfsgerechte Leistung mit skalierbaren GPUs für sich ändernde Arbeitslasten.

- Keine anfänglichen Hardwareinvestitionen oder laufenden Wartungskosten.

- Einfach zu erweiternde Rechenleistung während des KI-Trainings, Renderings oder großer Anwendungen.

- Nahtlose Integration in Cloud-Computing-Umgebungen, Automatisierungstools und Multi-Cloud-Plattformen.

- Eine starke Alternative zu On-Prem-GPU, wenn Sie mehr Flexibilität, schnellere Einrichtung und weniger Betriebskosten benötigen.

Physische GPU

- Vollständiges Eigentum an der Hardware, aber feste Ressourcen und begrenzte Skalierbarkeit.

- Höhere langfristige Kosten aufgrund von Strom, Kühlung und Komponenten-Upgrades.

- Erfordert manuelle Verwaltung von Sicherheit, Patches und Infrastrukturzuverlässigkeit.

- Besser geeignet für sehr spezifische oder konstante Arbeitslastanforderungen, bei denen die Nutzung nicht schwankt.

- Weniger anpassungsfähig als cloudbasierte Instanzen, insbesondere für Teams, die Machine-Learning-Pipelines oder mehrere Modelle betreiben.

Vorteile einer Cloud-GPU

Hohe Leistung für rechenintensive Arbeitslasten

Cloud-GPUs bieten starke, zuverlässige Leistung für anspruchsvolle Anwendungen wie KI-Modelle, maschinelles Lernen, Rendering und Simulationen. Durch den Zugriff auf leistungsstarke GPUs, die von einem Cloud-Anbieter gehostet werden, erhalten Sie die benötigte Rechenleistung, ohne lokale Hardware aufzurüsten.

Skalierbarkeit nach Bedarf

Wenn Ihre Arbeitslasten wachsen – vom Testen neuer Modelle bis hin zur Verarbeitung von Datenüberlastungen – können Sie GPU-Ressourcen in Sekunden skalieren. Dieses Maß an Flexibilität ist mit fest installierter Hardware einfach nicht möglich.

Kosten-Effizienz und reduzierte Hardware-Investitionen

Cloud-GPUs beseitigen die anfänglichen Kosten für physische Karten und die laufenden Kosten für Kühlung, Strom und Wartung. Sie zahlen nur für das, was Sie nutzen, was Ihnen hilft, effizienter zu budgetieren und es einfacher macht, Preise zu vergleichen oder eine Migration von älterer Infrastruktur zu planen.

Schnellere Bereitstellung und reduzierte Wartung

Da der Cloud-Anbieter Installation, Updates und Sicherheit verwaltet, ist die Bereitstellung schnell und unkompliziert. Sie können Instanzen für Tests, KI-Training oder schwerere Arbeitslasten ohne physische Einrichtung starten, sodass sich die Teams auf den Aufbau von Anwendungen anstatt auf die Verwaltung von Hardware konzentrieren können.

Beliebte Anwendungsfälle für Cloud-GPUs

KI- und maschinelles Lernen Arbeitslasten

Cloud-GPUs sind ideal für das Training von KI-Modellen und das Durchführen von ML-Experimenten, die starke Leistung und schnelle Verarbeitung benötigen. Sie ermöglichen es Ihnen, große Datensätze zu verarbeiten, verschiedene Architekturen zu testen und Ihre Ressourcen zu skalieren, während Ihre Arbeitslasten wachsen – alles ohne den Kauf spezialisierter Hardware.

3D-Rendering und grafikintensive Anwendungen

Künstler, Designer und Entwickler nutzen Cloud-GPUs, um das Rendering und die visuellen Effekte zu beschleunigen. Mit leistungsstarken GPUs, die auf Abruf verfügbar sind, können Sie Wartezeiten reduzieren, mehrere Projekte gleichzeitig ausführen und reibungslos über verschiedene Plattformen und Umgebungen hinweg arbeiten.

High Performance Computing (HPC)

Für wissenschaftliche Forschung, Simulationen und andere rechenintensive Aufgaben bieten Cloud-GPUs die Leistung und Skalierbarkeit, die erforderlich sind, um komplexe Berechnungen schnell zu verarbeiten. Sie sind eine praktische Option für Teams, die zuverlässige Leistung wünschen, ohne ihre eigene HPC-Infrastruktur verwalten zu müssen.

Big Data-Analysen und Simulationen

Cloud-GPUs sind hervorragend geeignet, um große Datenmengen zu verarbeiten, was sie nützlich für Analysen, Prognosen und großangelegte Simulationen macht. Durch die Kombination von GPU-Verarbeitung mit anderen Cloud-Computing-Diensten können Organisationen schneller Erkenntnisse gewinnen und die Kapazität an den Spitzenbedarf anpassen.

Sicherheits- und Compliance-Überlegungen

Cloud-GPUs verwenden starke Isolation, um Ihre Daten, Modelle und Arbeitslasten von anderen Mandanten zu trennen. Die Virtualisierung sorgt für eine sichere Verarbeitung auf jeder GPU, während der Cloud-Anbieter Patches und Schutzmaßnahmen für die zugrunde liegende Infrastruktur verwaltet.

Die meisten Plattformen folgen anerkannten Compliance-Standards und bieten Verschlüsselung, kontrollierten Zugriff und sicheres Networking über verschiedene Umgebungen hinweg. Dies hilft Ihnen, einen zuverlässigen, konformen Service aufrechtzuerhalten, während Sie GPUs skalieren, Arbeitslasten migrieren oder sich mit umfassenderen Cloud-Computing-Tools integrieren.

Wie man seine Cloud-GPU auswählt

Leistungsanforderungen (Speicher, Kerne, Verarbeitungsleistung)

Beginnen Sie damit, den Speicher, die Kernanzahl und die Verarbeitungskapazität der GPU an Ihre Arbeitslasten anzupassen. KI-Modelle, Rendering und maschinelles Lernen benötigen oft höhere Leistung und spezialisiertere Hardware, während leichtere Anwendungen bequem auf kleineren Instanzen laufen können.

Skalierbarkeit und Flexibilität für sich ändernde Arbeitslasten

Wenn Ihre Nutzung variiert oder Sie ein schnelles Wachstum erwarten, wählen Sie eine Konfiguration, die sich leicht skalieren lässt. Cloud-GPUs ermöglichen es, Ressourcen nach Bedarf anzupassen und bieten die Flexibilität, die für sich entwickelnde Arbeitslasten, Tests oder mehrstufige Trainingszyklen erforderlich ist.

Kostenbewertung und Preismodelle

Vergleichen Sie die Preise basierend auf Ihren tatsächlichen Nutzungsmustern. Einige Teams bevorzugen stündliche oder monatliche Abrechnung, während andere von reservierten Optionen für vorhersehbare Arbeitslasten profitieren. Achten Sie auf die Gesamtkosten, einschließlich Speicher und Netzwerkverkehr, wenn Sie Upgrades oder Migrationen planen.

Integration mit bestehender Cloud-Infrastruktur

Stellen Sie sicher, dass die Cloud-GPU nahtlos in Ihre aktuelle Infrastruktur, Tools und Bereitstellungspipelines passt. Sie können GPU-Instanzen mit Speicher, Orchestrierungsframeworks und anderen Cloud-Computing-Diensten kombinieren, um die Abläufe zu optimieren.

Netzwerk- und Datentransferraten

Schnelle Netzwerke helfen beim Verschieben großer Datensätze oder beim Ausführen verteilter Modelle. Achten Sie auf Hochgeschwindigkeitsoptionen, latenzarme Verbindungen und eine reibungslose Integration über Plattformen und Umgebungen hinweg, insbesondere für KI-Infrastruktur oder das Training mit mehreren Knoten.

Support, Zuverlässigkeit und SLA

Zuverlässiger Support und klare SLAs helfen, die Stabilität während des gesamten Servicelebenszyklus zu gewährleisten. Dies ist wichtig, wenn kritische Anwendungen ausgeführt, mehrere Pipelines verwaltet oder auf einen Cloud-Anbieter für langfristige Operationen vertraut wird.

Implementierung von Cloud-GPUs mit OVHcloud

Verfügbare GPU-Instanzen und Konfigurationen

OVHcloud bietet GPU-Instanzen, die für alles von schnellen Experimenten bis hin zu großem KI-Training und hochleistungsfähigen Workloads geeignet sind. Sie können Konfigurationen basierend auf Speicher, Verarbeitungsbedarf oder den spezifischen Anforderungen Ihrer Anwendungen auswählen, sei es für maschinelles Lernen, Rendering oder datenintensive Modelle.

API-Integration, Automatisierung und Orchestrierungstools

Bereitstellung und Skalierung sind dank API-Zugriff und Automatisierungstools unkompliziert. Diese ermöglichen es Ihnen, Ressourcen konsistent über verschiedene Umgebungen hinweg zu verwalten, was die Migration und Orchestrierung beim Verschieben von Workloads zu Cloud-GPUs erleichtert.

Best Practices zur Maximierung von Leistung und Kosteneffizienz

Für das beste Gleichgewicht zwischen Leistung und Kosten sollten Sie GPU-Typen an Ihre Workloads anpassen, die Nutzung überwachen und Überprovisionierung vermeiden. Die Kombination von Cloud-GPUs mit Speicher, Netzwerk und anderen Cloud-Computing-Diensten hilft, die Effizienz aufrechtzuerhalten, während Sie die KI-Infrastruktur skalieren oder mehrere Modelle ausführen.

Zugriff auf Cloud-GPUs mit OVHcloud

OVHcloud bietet skalierbare Cloud-GPU-Instanzen, vorhersehbare Preise und eine einfache Integration in breitere Cloud-Computing-Dienste, was es einfach macht, KI-Modelle, maschinelle Lernpipelines und andere hochleistungsfähige Workloads auszuführen, ohne physische Hardware verwalten zu müssen.

GPU-Instanzen

Entdecken Sie flexible, bedarfsgerechte GPU-Instanzen, die für KI-Training, Rendering und rechenintensive Anwendungen konzipiert sind. Wählen Sie aus mehreren Konfigurationen, die für Speicher, Verarbeitungsleistung und anspruchsvolle Workloads optimiert sind, damit Sie Projekte schnell starten und mühelos über Umgebungen hinweg skalieren können, mit der starken Leistung, die Sie benötigen.

GPU-dedizierte Server

Führen Sie KI-Training und rechenintensive Aufgaben auf GPU-dedizierten Servern aus, die für maximale Kontrolle und Leistung konzipiert sind. Mit exklusivem Zugriff auf leistungsstarke GPU-Hardware und vollständiger Anpassung Ihrer Umgebung können Sie große Modelle vorantreiben, komplexe Pipelines verwalten und sicher von Tests in die Produktion skalieren.

Hochleistungs-Lösungen

Zugriff auf spezialisierte Rechenoptionen für Simulationen, Analysen, HPC-Aufgaben und datenintensive Workloads. Diese Lösungen bieten konsistente Leistung, integrieren sich nahtlos mit GPU-Ressourcen und dedizierten Servern und bieten eine zuverlässige Grundlage für komplexe, mehrstufige Projekte. Sie können sie nach Anwendungsfall vergleichen, um diejenige zu finden, die am besten zu Ihren Bedürfnissen passt.