Efektywność i suwerenność danych: Lector automatyzuje przetwarzanie dokumentów przy użyciu AI

OVHcloud i Lector

Managed Kubernetes i usługi AI do automatyzacji procesów biznesowych

Inteligentne przetwarzanie - oszczędność czasu o 80%

Hosting zgodny z europejskimi standardami suwerenności danych

W skrócie

Rozwiązanie Lector AI umożliwia w pełni zautomatyzowane przetwarzanie dokumentów przychodzących, takich jak listy, e-maile czy pliki przesyłane przez aplikacje. W oparciu o AI klasyfikuje je i automatycznie wyodrębnia dane. Technologia open source, zintegrowane usługi zarządzane i skalowalna infrastruktura pozwalają zaoszczędzić ponad 80% czasu, utrzymać wysoką jakość i zapewnić realne korzyści klientom.

Z inteligentnej platformy korzysta ponad 60 aktywnych klientów korporacyjnych, w tym ponad 25 podmiotów z sektora ubezpieczeń zdrowotnych. W sumie platforma przetworzyła już ponad 500 milionów stron. Rozwiązanie usprawnia obsługę całej korespondencji przychodzącej, obejmującej zarówno pocztę tradycyjną, jak i kanały cyfrowe.

Wyzwanie

Niezbędna zaufana infrastruktura chmurowa do realizacji skalowalnych procesów AI w Niemczech

Przed migracją do OVHcloud firma Lector uruchamiała swoje środowiska produkcyjne na infrastrukturze jednego z dużych amerykańskich dostawców chmury, wykorzystując Kubernetes i maszyny wirtualne. Dalsze skalowanie ograniczały jednak trzy kluczowe problemy. Po pierwsze, nie było możliwości integracji zarządzanych usług open source, takich jak MongoDB i Kafka. Po drugie, koszty transferu danych były wysokie. Po trzecie, lokalizacja pierwotnego dostawcy poza Europą obniżała zaufanie klientów.

Dotyczyło to szczególnie podmiotów, dla których zgodność z RODO i suwerenność danych są kluczowe, zwłaszcza w niemieckim sektorze ubezpieczeń zdrowotnych, administracji publicznej oraz w wielu prywatnych przedsiębiorstwach. Zmiana infrastruktury była zatem konieczna, aby Lector mógł dalej rozwijać swoje innowacje.

Rozwiązanie

Europejskie zarządzane usługi chmurowe, skalność i wsparcie biznesowe

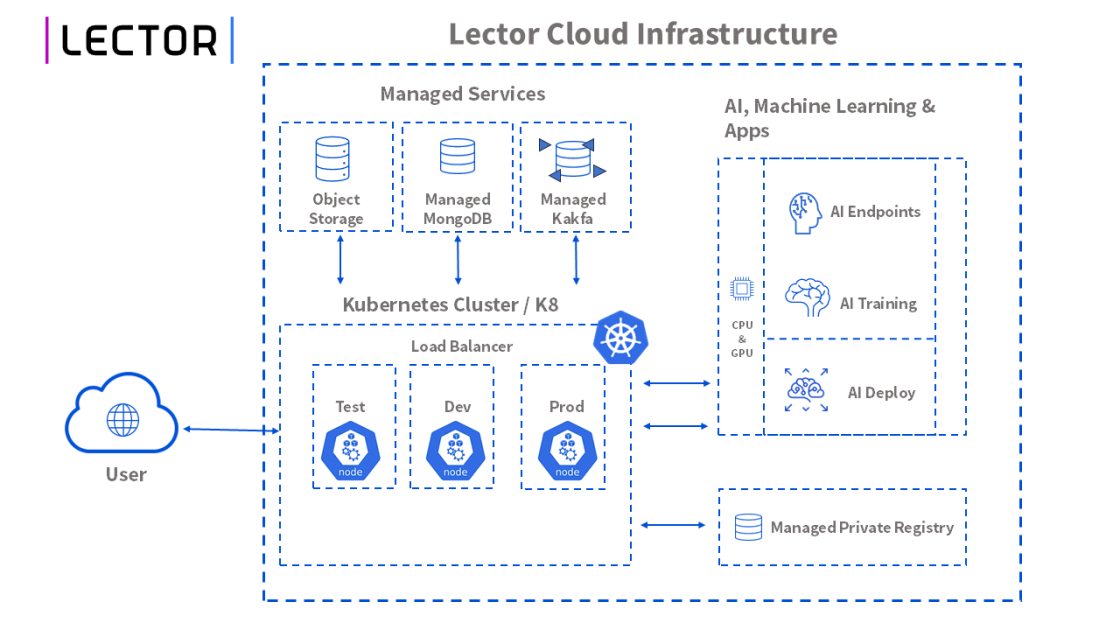

Lector wspólnie z OVHcloud wdrożył zarządzane klastry Kubernetes oraz Object Storage kompatybilny z S3, co umożliwia przechowywanie dokumentów bez ograniczeń skalowania. Do przetwarzania i analizy dokumentów Lector wykorzystuje usługi AI, w tym AI Training, AI Deploy oraz AI Endpoint.

System działa w niemieckim centrum danych OVHcloud i zapewnia wysoką dostępność oraz niezawodność, w szczególności dla węzłów GPU i baz danych. Cała infrastruktura jest monitorowana centralnie, a wszystkie kluczowe metryki są od razu widoczne w Prometheusie, co stanowi dużą wartość w porównaniu z innymi dostawcami chmury, zwłaszcza w przypadku usług zarządzanych.

AI Endpoints zapewnia elastyczny dostęp do różnych modeli AI. Dzięki temu możemy rozwijać działalność w dłuższej perspektywie i wzmacniać innowacyjność, tworząc własne narzędzia analityczne oraz platformę data i business intelligence.

Dr Benjamin von Ardenne, founder and managing director, lector.ai GmbH

Korzyści

Większa wydajność dzięki automatyzacji i koncentracji na rozwoju

Dzięki usługom zarządzanym OVHcloud zespół poświęca znacznie mniej czasu na utrzymanie i skalowanie Kafka oraz MongoDB. Może w pełni skupić się na dalszym rozwoju platformy i aplikacji. Istotną rolę odegrał OVHcloud Startup Program, ponieważ umożliwił testowanie i ocenę szerokiego zakresu usług oraz ułatwił wymianę wiedzy ze społecznością specjalistów z obszaru AI i infrastruktury chmurowej.

Lector to platforma AI, która w pełni automatyzuje przetwarzanie dokumentów przychodzących - od ich wstępnego przygotowania i klasyfikacji po precyzyjne wyodrębnianie danych. Zaawansowane modele AI rozpoznają różne typy dokumentów i upraszczają procesy, co przekłada się na dużą oszczędność czasu i zasobów.

Dr Benjamin von Ardenne, founder and managing director, lector.ai GmbH

Hosting infrastruktury Lector w suwerennej chmurze w Europie przynosi wymierne korzyści klientom firmy. Mają oni pewność, że ich dane i dokumenty są bezpiecznie zarządzane w oparciu o europejskie technologie.

Dowiedz się więcej o firmie Lector.