Cos'è l'apprendimento per il rinforzo?

L’apprendimento rafforzato è un tipo di Machine Learning affascinante in cui un agente impara a prendere decisioni interagendo con un ambiente. Immaginate un robot che impara a navigare in un labirinto: prova diverse strade, riceve ricompense per essersi avvicinato all'uscita e penalità per aver colpito dei muri.

Con il tempo, il robot impara il percorso ottimale attraverso tentativi ed errori, massimizzando i suoi premi. Questo processo riflette il modo in cui gli esseri umani e gli animali imparano dall'esperienza, rendendo l'apprendimento per il rinforzo un potente strumento per creare sistemi intelligenti.

Breve spiegazione di come funziona l’apprendimento per il rafforzamento

In sostanza, l’apprendimento per il rafforzamento implica un feedback continuo tra l’agente e il suo ambiente. L'agente intraprende un'azione, osserva la risposta dell'ambiente e riceve una ricompensa o una penalità. Questo feedback aiuta l'agente a imparare quali azioni portano a risultati positivi e quali evitare. L'obiettivo dell'agente è sviluppare una strategia, denominata politica, che massimizzi i suoi premi cumulativi nel tempo.

L’apprendimento rafforzato ha trovato applicazioni in un’ampia gamma di settori, dalla robotica al gioco, alla finanza e all’assistenza sanitaria. La sua capacità di imparare dalle interazioni con ambienti complessi lo rende uno strumento prezioso per lo sviluppo di sistemi intelligenti in grado di adattarsi e migliorare nel tempo.

Se conosci i fondamenti dell’apprendimento per il rinforzo, sarai sulla buona strada per esplorare le entusiasmanti possibilità che questo campo ha da offrire.

Dove si inserisce l’apprendimento per il rinforzo nell’IA e nel ML?

L’apprendimento rafforzato è un sottosettore distinto del Machine Learning , che si affianca all’apprendimento supervisionato e al Deep Learning . Mentre l'apprendimento supervisionato si basa su dati etichettati per l'addestramento e l'apprendimento non supervisionato si concentra sull'individuazione di modelli in dati non etichettati, l'apprendimento RL avviene attraverso l'interazione con un ambiente. Un agente RL riceve feedback sotto forma di premi o penali, definendo il proprio comportamento per massimizzare i premi cumulativi nel tempo.

RL svolge un ruolo cruciale nell’Intelligenza Artificiale (IA) consentendo agli agenti di imparare e prendere decisioni in ambienti complessi. I sistemi di IA mirano a mostrare un comportamento intelligente, e RL fornisce una struttura per raggiungere questo obiettivo attraverso tentativi ed errori, proprio come il modo in cui gli esseri umani imparano. Gli algoritmi RL possono essere incorporati di IA, come la robotica, il gioco e i sistemi autonomi, per sviluppare capacità decisionali intelligenti.

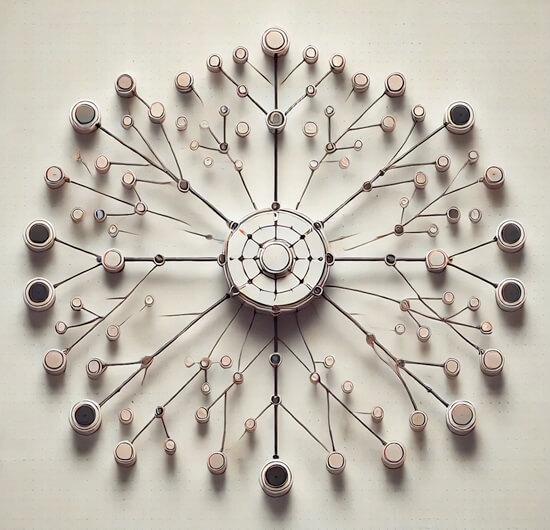

Componenti chiave dell'apprendimento per il rafforzamento

Alla base, l’apprendimento per il rafforzamento (RL) è un quadro in cui un agente impara a prendere decisioni interagendo con un ambiente. Esaminiamo ora ciascuno di questi componenti:

Agente

L'agente è lo studente e il responsabile delle decisioni in questa impostazione. Potrebbe essere un robot che impara a navigare, un programma software che gestisce un gioco, o qualsiasi entità che percepisca l'ambiente circostante e intraprenda azioni.

In RL, l'obiettivo principale dell'agente è quello di trovare la migliore strategia d'azione, nota come politica, per massimizzare una ricompensa cumulativa nel tempo. Lo fa osservando l'ambiente, selezionando le azioni e ricevendo feedback sotto forma di premi. Tramite tentativi ed errori, l'agente perfeziona la propria politica per prendere decisioni migliori in futuro.

Ambiente

L'ambiente include tutto ciò con cui l'agente interagisce. Fornisce il contesto in cui l'agente opera e reagisce alle azioni dell'agente passando a nuovi stati e fornendo premi.

Potrebbe trattarsi di un mondo fisico (come un labirinto per un robot) o virtuale (come un simulatore di gioco). La complessità dell'ambiente può variare in modo significativo, da semplici mondi di grid computing a scenari complessi del mondo reale.

Stato

Lo stato descrive la situazione corrente dell'agente nell'ambiente. Si tratta di uno snapshot che acquisisce tutte le informazioni rilevanti di cui l'agente ha bisogno per prendere una decisione.

In una partita a scacchi, lo stato è la configurazione di tutti i pezzi sulla scacchiera. Per un'auto a guida autonoma, lo stato include la sua posizione, la sua velocità e il traffico circostante. Lo stato è essenziale perché fornisce il contesto per le azioni dell'agente e lo aiuta a comprendere le conseguenze delle sue scelte.

Azione

Le azioni sono scelte che l'agente può fare per influenzare l'ambiente. Lo spostamento di un pezzo degli scacchi o la rotazione del volante di un'auto sono esempi di azioni. L'insieme di azioni possibili può essere discreto (un numero limitato di scelte) o continuo (un intervallo di valori). La capacità dell'agente di selezionare azioni appropriate è fondamentale per raggiungere i propri obiettivi e massimizzare i premi.

Ricompensa

Il premio è il meccanismo di feedback che guida il processo di apprendimento dell'agente. È un segnale numerico che indica quanto buona o cattiva era un'azione in uno stato particolare.

I premi positivi incoraggiano l'agente a ripetere le azioni che portano a loro, mentre i premi negativi (spesso chiamati penali) scoraggiano alcuni comportamenti. Il segnale di ricompensa è un elemento chiave per definire la politica dell'agente e guidarla verso un processo decisionale ottimale.

L'interazione tra queste componenti costituisce la base dell'apprendimento per il rafforzamento. L'agente interagisce continuamente con l'ambiente, intraprendendo azioni basate sullo stato corrente e ricevendo premi come feedback. Apprendendo da questo feedback, l'agente migliora gradualmente la propria politica, diventando più abile nel raggiungere i propri obiettivi all'interno dell'ambiente.

Tipi di algoritmi di apprendimento del rinforzo

Gli algoritmi di apprendimento del rafforzamento possono essere classificati in base a diverse distinzioni chiave, ognuna con i propri punti di forza e di debolezza:

Basato su modello vs. Senza modello

La prima distinzione sta nel fatto che un algoritmo modella esplicitamente l'ambiente. Gli algoritmi basati su modelli apprendono un modello della dinamica dell'ambiente, prevedendo come cambierà in risposta alle azioni.

Questo modello guida quindi il processo decisionale, consentendo all'agente di pianificare in anticipo e simulare i potenziali risultati. Gli algoritmi privi di modello, invece, imparano direttamente una politica o una funzione di valore senza creare un modello esplicito. Per migliorare le proprie decisioni, si basano esclusivamente sull'esperienza e sul processo "prova ed errore".

Basato sul valore rispetto a Basato su regole

Un'altra differenza chiave è nel modo in cui gli algoritmi imparano. Gli algoritmi basati sul valore apprendono una funzione di valore che stima il premio previsto a lungo termine per ogni coppia di stato o azione-stato.

Quindi utilizzano questa funzione per selezionare azioni che massimizzino i premi futuri previsti. Gli algoritmi basati su regole imparano direttamente la politica, ossia la mappatura degli stati alle azioni. Ottimizzano questa politica per massimizzare il premio cumulativo previsto.

On-Policy vs. Non incluso nella politica

Il modo in cui gli algoritmi imparano dall'esperienza porta alla distinzione tra metodi non-policy e non-policy. Gli algoritmi basati sulle policy si basano esclusivamente sull'esperienza generata dalle policy correnti.

Questo significa che devono continuamente esplorare e raccogliere nuovi dati per migliorare. Gli algoritmi off-policy possono imparare dall’esperienza generata da una politica diversa, che permette loro di sfruttare l’esperienza passata e imparare in modo più efficiente.

Apprendimento approfondito del rinforzo

Il Deep Rafforzement Learning (DRL) combina l’apprendimento per il rafforzamento con le reti neurali profonde. Queste reti sono potenti approssimatori funzionali che possono imparare modelli e relazioni complesse in dati ad alta dimensione.

DRL ha dimostrato un notevole successo nella risoluzione di problemi impegnativi, come la padronanza di giochi complessi come Go e StarCraft II e il controllo dei robot in ambienti reali.

Ognuna di queste categorie rappresenta un approccio diverso all'apprendimento rafforzato, con i propri vantaggi e inconvenienti. La comprensione di queste distinzioni è fondamentale per scegliere l'algoritmo giusto per un compito specifico e personalizzarlo per ottenere prestazioni ottimali.

Sfide nell'apprendimento per il rafforzamento

L’apprendimento rafforzato, nonostante i suoi notevoli risultati, presenta una serie di sfide che i ricercatori e gli operatori del settore devono affrontare:

Esplorazione vs. Sfruttamento

Uno dei principali dilemmi di RL è il compromesso tra esplorazione e sfruttamento. L'agente deve esplorare l'ambiente per scoprire nuove azioni e stati potenzialmente gratificanti.

Tuttavia, deve anche sfruttare le sue attuali conoscenze per massimizzare i suoi vantaggi. Trovare il giusto equilibrio tra questi due obiettivi è fondamentale. Una quantità eccessiva di esplorazioni può portare a un apprendimento inefficiente, mentre un utilizzo eccessivo può impedire all'agente di trovare soluzioni ottimali.

Problema di assegnazione del credito

Il problema di assegnazione del credito si verifica quando un agente riceve un premio dopo una sequenza di azioni. Determinare quali azioni nella sequenza sono state responsabili del premio può essere difficile.

È stato il primo passo che ha gettato le basi per il successo, o è stata una decisione successiva che ha siglato l'accordo? Assegnare credito in modo appropriato è essenziale per apprendere politiche efficaci.

Curva di quotatura

La maledizione della dimensionalità si riferisce alla crescita esponenziale del numero di stati e azioni man mano che la complessità dell'ambiente aumenta. Negli spazi ad alta dimensione, diventa sempre più difficile rappresentare e imparare funzioni di valore o politiche in modo efficace. Questo può portare a un apprendimento lento, a previsioni imprecise e a performance non ottimali.

Queste sfide evidenziano le complessità legate alla progettazione e all’implementazione di algoritmi di apprendimento per il rafforzamento. I ricercatori stanno sviluppando attivamente nuove tecniche e approcci per affrontare questi problemi e superare i limiti di ciò che RL può raggiungere.

Progressi nell'apprendimento rafforzato

Un'area di interesse significativa è lo sviluppo di metodi basati sul valore e sulle politiche, che non si basano sulle ipotesi del modello. Questi metodi hanno rivoluzionato l'elaborazione e l'analisi dei dati, in particolare nel settore finanziario, consentendo di migliorare il processo decisionale in ambienti complessi. L’integrazione delle reti neurali con algoritmi RL ha ulteriormente migliorato le loro prestazioni, in particolare in applicazioni come il gioco e le soluzioni di addestramento dell’IA per strategie ottimali.

Concentrarsi sull'implementazione nel mondo reale

Un altro argomento critico è l'applicazione di RL negli scenari reali, che presenta sfide uniche. I ricercatori hanno identificato diversi problemi chiave che devono essere affrontati per rendere la ricerca e lo sviluppo praticabili per problemi reali. tra cui la necessità di algoritmi robusti e scalabili in grado di gestire la variabilità e l'imprevedibilità degli ambienti reali. Inoltre, la sicurezza e la confidenzialità dei sistemi RL sono diventate una preoccupazione sempre maggiore, con studi che hanno evidenziato le vulnerabilità che potrebbero portare a servizi inaffidabili o instabili.

Anche l’apprendimento offline per il potenziamento sta attirando l’attenzione, in quanto consente agli agenti di imparare dai dataset pre-raccolti, riducendo la necessità di una costosa raccolta di dati online. Questo approccio è particolarmente importante per i sistemi consigliati, in cui sono prontamente disponibili dataset offline di grandi dimensioni. Tuttavia, la RL offline si trova ad affrontare sfide legate all'efficienza dei dati e alla necessità di algoritmi solidi in grado di gestire distrazioni visive e cambiamenti nella dinamica.

Fusione di DRL e GNN

Un altro argomento emergente è costituito dalla fusione del Deep Restrengthening Learning (DRL) con altre tecniche avanzate, come le reti neurali a grafo (GNN). Questa combinazione ha lo scopo di migliorare l'utilità e l'applicabilità di RL in ambienti complessi e strutturati in grafici, affrontando problemi come la generalizzazione e la complessità computazionale. Inoltre, l’implementazione di sistemi DRL su diverse piattaforme, tra cui server/cloud, sistemi mobili/embedded e motori di gioco, ha rivelato numerose sfide legate all’interazione e alla comunicazione ambientale.

Applicazioni di Apprendimento rinforzo

La versatilità dell'apprendimento rafforzato ha portato alla sua adozione in un'ampia gamma di settori, mostrando il suo potenziale di rivoluzionare il modo in cui risolviamo problemi complessi:

Robotica e sistemi di controllo

RL si è affermato come un potente strumento per addestrare i robot a eseguire attività complesse in ambienti reali. I robot possono imparare a camminare, afferrare oggetti e persino eseguire intricate manipolazioni interagendo con l'ambiente circostante e ricevendo feedback sotto forma di premi. Questo approccio permette ai robot di adattarsi a situazioni dinamiche e imprevedibili, rendendoli più autonomi e capaci.

Game Play

RL ha attirato un'attenzione significativa per i suoi successi nel gioco. Algoritmi come AlphaGo e AlphaZero hanno dimostrato performance sovrumane in giochi come Go, chess e Shogi, spingendo i limiti di ciò che l’IA può raggiungere. Gli agenti RL apprendono strategie ottimali giocando contro se stessi e perfezionando il proprio processo decisionale attraverso milioni di iterazioni.

Settore sanitario

Nel settore sanitario, RL promette piani terapeutici personalizzati e processi decisionali ottimizzati. Gli algoritmi RL possono imparare a consigliare trattamenti, aggiustare i dosaggi dei farmaci e persino controllare dispositivi medici come le protesi. Analizzando i dati dei pazienti e ottimizzando i risultati desiderati, la RL può potenzialmente migliorare l’assistenza ai pazienti e portare a migliori risultati in termini di salute.

Finanza

Anche il settore finanziario sta esplorando il potenziale della RL. Gli algoritmi possono imparare a prendere decisioni di trading ottimali, gestire portafogli e persino valutare i rischi di credito. La capacità di RL di adattarsi alle mutevoli condizioni di mercato e di ottimizzare i profitti a lungo termine lo rende uno strumento prezioso per le istituzioni finanziarie.

Sistemi di raccomandazione

I sistemi consigliati sono un'altra area in cui l'RL sta avendo un impatto. Grazie alle interazioni e ai feedback degli utenti, gli algoritmi RL consentono di personalizzare i suggerimenti per prodotti, film, musica e altro ancora. Questo non solo migliora l'esperienza utente, ma anche l'efficacia delle campagne di marketing e pubblicitarie.

Futuro dell'Apprendimento rafforzato

L’apprendimento rafforzato (RL) è destinato a svolgere un ruolo sempre più centrale nel plasmare il futuro dell’intelligenza artificiale e delle sue applicazioni in vari settori. Diversi trend e progressi chiave puntano verso un futuro brillante per RL, promettendo di sbloccare nuovi livelli di autonomia, capacità decisionali e capacità di risoluzione dei problemi.

Uno dei prospect più entusiasmanti per l’RL è lo sviluppo di algoritmi in grado di adattarsi ad ambienti e attività sempre più complessi. Gli attuali metodi RL sono spesso in conflitto con gli spazi di stato ad alta dimensione e gli orizzonti a lungo termine, ostacolandone l'applicabilità negli scenari reali. Tuttavia, la ricerca in corso si concentra sullo sviluppo di algoritmi più scalabili ed efficienti in grado di affrontare queste sfide.

Tecniche come l'apprendimento per rinforzo gerarchico, l'RL distribuito e il meta-apprendimento stanno mostrando risultati promettenti nel migliorare la scalabilità e ridurre la complessità dei campioni.

Man mano che l’RL diventa sempre più diffusa nelle applicazioni del mondo reale, le considerazioni etiche e sociali assumeranno un’importanza sempre maggiore. Garantire equità, trasparenza e responsabilità negli algoritmi RL sarà fondamentale per evitare conseguenze indesiderate e pregiudizi.

Inoltre, affrontare le preoccupazioni in materia di migrazione dei posti di lavoro, privacy e sicurezza sarà essenziale per garantire l'implementazione responsabile e vantaggiosa della tecnologia RL.

L’obiettivo finale di molti ricercatori di IA è lo sviluppo dell’Intelligenza Artificiale Generale (AGI), un sistema in grado di imparare ed eseguire qualsiasi compito intellettuale che possa essere svolto da un essere umano.

Mentre l'AGI rimane un'aspirazione lontana, l'RL è considerato un componente chiave per il suo raggiungimento. Consentendo agli agenti di apprendere e adattarsi in ambienti complessi e dinamici, RL fornisce una struttura per lo sviluppo di sistemi intelligenti in grado di generalizzare le proprie conoscenze e competenze a nuove situazioni.

Utilizzare OVHcloud per l’Apprendimento rafforzato

OVHcloud offre una gamma di servizi in grado di assistere in modo significativo nei progetti di apprendimento rafforzato:

Risorse di calcolo ad alte prestazioni:

RL richiede spesso una notevole potenza di calcolo, in particolare per l'addestramento di modelli complessi e ambienti di simulazione. OVHcloud fornisce diverse soluzioni di calcolo ad alte prestazioni, tra cui istanze GPU e cluster, che consentono formazione e sperimentazione più rapide.

Storage scalabile:

I progetti RL possono generare enormi quantità di dati, ad esempio dataset di formazione, log e checkpoint dei modelli. Le opzioni di storage scalabile di OVHcloud, come lo storage di oggetti e lo storage di blocchi, assicurano un ampio spazio per archiviare e gestire i dati in modo efficiente.

Data processing e analytics:

OVHcloud offre strumenti e servizi per l’elaborazione e l’analisi dei dati, essenziali per analizzare i dati di addestramento, valutare le prestazioni dei modelli ed estrarre informazioni per migliorare gli algoritmi RL.

IA e Machine Learning:

OVHcloud fornisce una suite di strumenti e servizi di IA e Machine Learning, come AI Notebooks e AI Training, che possono semplificare lo sviluppo e la distribuzione di modelli di URL. Questi strumenti possono semplificare il processo di creazione e formazione degli agenti RL, riducendo il tempo e lo sforzo necessari.

Infrastruttura flessibile:

L’infrastruttura Cloud di OVHcloud è flessibile e adattabile, per permettere di aumentare o diminuire le risorse in base alle necessità e ai progetti di RL. In questo modo è possibile pagare solo le risorse utilizzate, ottimizzandone i costi e l'utilizzo.

In generale, la suite completa di servizi di OVHcloud può fornire una solida base per progetti di apprendimento rafforzato. Utilizzando l'infrastruttura, gli strumenti e il supporto di OVHcloud, è possibile concentrarsi sullo sviluppo e il perfezionamento degli algoritmi RL, accelerando le attività di ricerca e sviluppo e raggiungendo gli obiettivi del progetto in modo più efficiente.

OVHcloud e l’apprendimento rafforzato

AI Deploy

Implementa facilmente modelli e applicazioni di Machine Learning in produzione, crea punti di accesso alle API in tutta semplicità e fa previsioni efficaci.

AI Training

Addestra i modelli di IA, Machine Learning e Deep Learning in modo semplice ed efficiente e ottimizza l’utilizzo della GPU.