Cos'è l'High Performance Computing (HPC)?

Il termine High Performance Computing (HPC) indica l'implementazione di supercomputer e cluster di computer per risolvere problemi di calcolo complessi a velocità molto elevate. Questa tecnologia utilizza la potenza di più processori che lavorano in parallelo per gestire enormi dataset, spesso funzionando a velocità superiori di oltre un milione di volte rispetto ai computer desktop o ai server tradizionali.

Questi sistemi possono eseguire quadrilioni di calcoli al secondo, superando di gran lunga le capacità di computer e postazioni di lavoro normali. Ecco perché vengono spesso utilizzati per affrontare grandi problemi in ambito scientifico, ingegneristico e aziendale come fluidodinamica computazionale, data warehousing, elaborazione di transazioni e creazione e test di prototipi virtuali.

Perché l'HPC è importante?

Il calcolo ad alte prestazioni è fondamentale per diverse ragioni. Per prima cosa, permette di elaborare enormi quantità di informazioni e calcoli complessi a una velocità straordinaria, aspetto essenziale nel mondo odierno basato sui dati. Questa velocità elevata è fondamentale per rispondere a necessità specifiche in tempo reale (monitoraggio dello sviluppo di tempeste, test di nuovi prodotti o analisi delle tendenze azionarie, etc.).

L’HPC svolge un ruolo importante anche nell’avanzamento di ricerca scientifica, Intelligenza Artificiale e Deep Learning. Questi sistemi sono stati infatti determinanti nell'accelerazione del progresso scientifico e ingegneristico negli Stati Uniti, contribuendo all’evoluzione in materia di modellazione climatica, tecniche di produzione avanzate e sicurezza nazionale.

Grazie alla capacità di gestire carichi di lavoro complessi ed elaborare i dati quasi in tempo reale, questo approccio risulta particolarmente utile in settori come quello sanitario, aereo e manifatturiero. In generale, le simulazioni che supportano l’HPC possono ridurre o addirittura eliminare la necessità di test fisici, permettendo di risparmiare tempo e risorse.

Come funziona l’HPC?

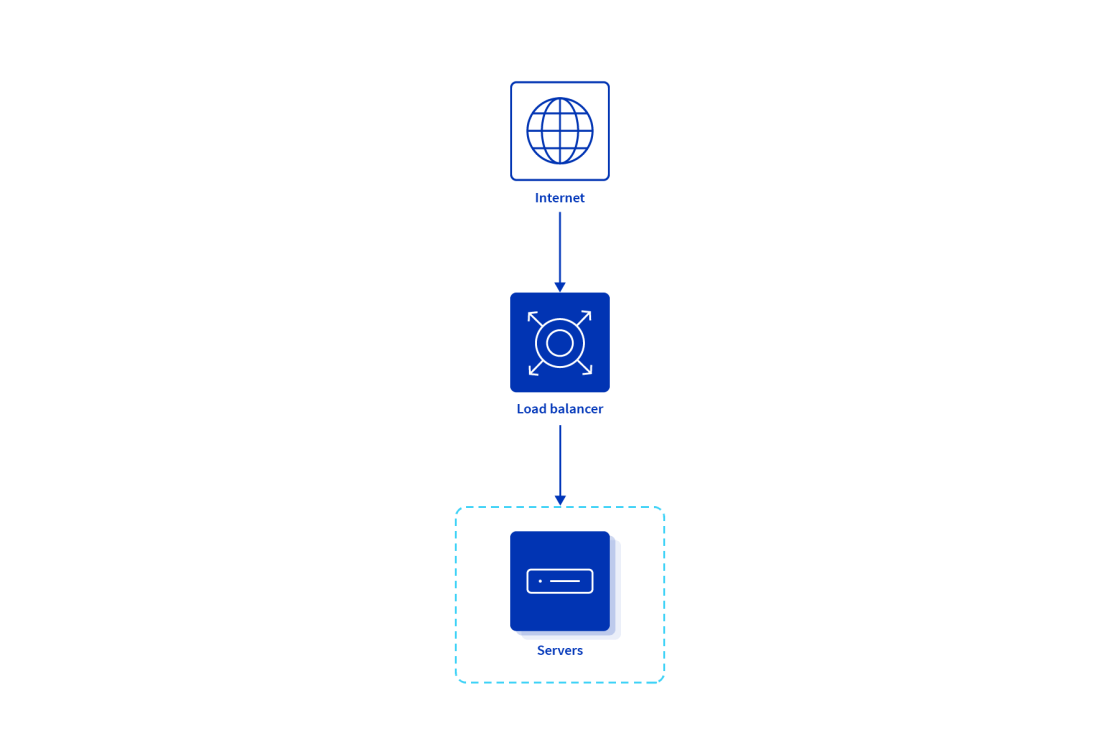

I sistemi HPC sono generalmente composti da centinaia o migliaia di server di calcolo, chiamati anche nodi, collegati in rete in un cluster. Questa tecnica è nota come elaborazione parallela ed è caratterizzata da diverse attività eseguite simultaneamente nei nodi.

Per funzionare al massimo delle prestazioni ogni componente del sistema, inclusi quelli di storage e di rete, deve seguire il ritmo degli altri. Per esempio, i componenti di storage devono essere in grado di inviare e ricevere le informazioni da e verso i server di calcolo appena vengono elaborate. Se un componente non riesce a stare al passo con gli altri, le prestazioni dell'infrastruttura ne risentono.

HPC nel Cloud computing

L’HPC nel Cloud computing combina la potenza di calcolo e la scalabilità del calcolo ad alte prestazioni tradizionale con la flessibilità e la natura on demand dei servizi Cloud.

Negli ambienti Cloud, gli utenti possono accedere e utilizzare quantità elevate di risorse di calcolo, tra cui potenza di elaborazione, memoria e storage, per eseguire attività complesse e ad alta intensità di risorse. Questi task includono simulazioni, ricerca scientifica, analisi dei dati e altri carichi di lavoro intensivi che richiedono grandi volumi di risorse di calcolo.

I carichi di lavoro HPC richiedono bassa latenza e banda passante elevata per una comunicazione tra nodi efficiente e, per facilitare questa comunicazione, i provider Cloud offrono opzioni di interconnessione veloce. Anche poter spostare efficientemente i dati è fondamentale e le piattaforme Cloud forniscono strumenti e soluzioni per trasferire in modo sicuro grandi dataset da e verso il Cloud.

Il deploy di sistemi ad alte prestazioni e basati sul Cloud presentano vantaggi come la scalabilità, che consente agli utenti di adattare le risorse di calcolo in base alle esigenze, e l'efficienza in termini di costi, in quanto i modelli cloud-based permettono di pagare solo le risorse implementate, eliminando la necessità di investire e mantenere costose infrastrutture on-premise.

Cos'è un cluster HPC?

Un cluster di calcolo ad alte prestazioni è un insieme di server interconnessi, chiamati nodi, che lavorano insieme per eseguire attività di calcolo complesse a velocità eccezionali.

Questi cluster sono progettati per gestire elaborazioni su larga scala e sono collegati tramite un'interconnessione veloce che consente loro di comunicare e gestire le informazioni in modo efficiente. I nodi all'interno di un cluster possono essere specializzati per eseguire diversi tipi di attività e in genere includono componenti quali core delle CPU, memoria e spazio disco, simili a quelli presenti nei personal computer ma con maggiore quantità, qualità e potenza.

Nodi di accesso

I nodi di accesso funzionano come gateway per l'accesso degli utenti al cluster. Sono utilizzati per attività come preparare script di invio per l’elaborazione in batch, inviare e monitorare job, analizzare risultati e trasferire dati. Non sono destinati all'esecuzione di job di calcolo o alla compilazione di software, che dovrebbero essere eseguiti su nodi di calcolo o, se necessario, tramite una sessione interattiva.

Nodi di calcolo

I nodi di calcolo rappresentano la forza motrice di un cluster, perché eseguono la maggior parte dei calcoli numerici. Pur avendo uno storage persistente minimo, questi nodi sono dotati di un’elevata memoria DRAM per gestire il carico di lavoro computazionale, che eseguono utilizzando risorse locali come CPU e, in alcuni casi, GPU.

Nodi di memoria estesa

I nodi di memoria estesa sono server specializzati all'interno di un cluster con una quantità di memoria significativamente maggiore rispetto ai normali nodi di calcolo. Sono progettati per gestire job con requisiti di memoria più elevati e sono essenziali per carichi di lavoro non adatti allo spazio di memoria dei nodi standard. I processi che richiedono una quantità di memoria superiore a quella disponibile nei nodi standard vengono in genere eseguiti su questi nodi.

Nodi GPU

I nodi GPU sono dotati di processori grafici (GPU) in aggiunta ai core CPU. Questi nodi sono ottimizzati per calcoli che possono essere eseguiti in parallelo su una GPU, accelerando in modo significativo alcuni tipi di calcoli, in particolare quelli adatti all’architettura delle GPU.

Nodi riservati o specializzati

I nodi riservati o specializzati sono server all'interno di un cluster configurati per attività specifiche o riservati a determinati utenti o gruppi. Questi nodi possono includere acceleratori o altri componenti hardware specializzati per rispondere a esigenze di calcolo specifiche o carichi di lavoro che richiedono risorse non presenti nei nodi di calcolo standard.

Casi d’uso dell’HPC

Il calcolo ad alte prestazioni è ottimale solo per alcune esigenze specifiche e presenta alcune sfide, di cui la principale è rappresentata dai costi associati a questi sistemi. Anche se in grado di elaborare rapidamente grandi quantità di informazioni, l'HPC potrebbe non essere necessario per attività che non richiedono queste velocità o ampi volumi di dati. L’High Performance Computing resta comunque fondamentale in molti ambienti e, senza di esso, alcune attività non sarebbero possibili.

Casi d’uso ottimali dell’HPC

L'HPC risponde a diverse esigenze in numerosi settori e ambiti scientifici. Ecco alcuni esempi specifici in cui è particolarmente indicato:

- Sanità e scienze biologiche: l’HPC riesce a elaborare dati in tempo quasi reale per eseguire diagnosi, test clinici o interventi medici immediati. È utilizzato anche per studiare biomolecole e proteine nelle cellule umane per sviluppare nuovi farmaci e terapie mediche ed è essenziale per realizzare modelli e simulazioni del cervello umano.

- Settore aerospaziale e manifatturiero: i sistemi ad alte prestazioni permettono di ottimizzare i materiali utilizzati nella produzione. La ricerca computazionale consente alle aziende di creare componenti più duraturi con una quantità minore di materiali. L’HPC viene utilizzato anche per simulare linee di assemblaggio e comprendere i processi per migliorare l'efficienza.

- Energia e ambiente: l'HPC è utilizzato per la ricerca sul clima, inclusa la modellazione e simulazione di modelli climatici. È impiegato anche per sviluppare un'agricoltura sostenibile e analizzare i fattori di sostenibilità. L'HPC svolge un ruolo determinante nell’avanzamento delle scoperte nell’ambito di energia nucleare, fusione nucleare, energia rinnovabile ed esplorazione spaziale.

- IA e Machine Learning: l'HPC può anche supportare altre forme di elaborazione, ad esempio per eseguire modelli di IA su larga scala in campi come teoria cosmica, astrofisica, fisica e gestione di insiemi non strutturati.

Questi sono solo alcuni esempi, a cui si aggiungono i servizi finanziari, in cui il calcolo ad alte prestazioni viene usato per eseguire analisi per la valutazione dei rischi finanziari e la previsione delle tendenze di mercato, e le aziende di media e intrattenimento, che implementano l'HPC per il rendering, l'elaborazione audio e video per la produzione multimediale. Anche all’interno delle istituzioni governative, il calcolo ad alte prestazioni offre numerose possibilità, come l'analisi dei dati del censimento o generati dall'Internet of Things (IoT), oppure la realizzazione di progetti infrastrutturali su larga scala.

Casi d'uso meno indicati per l'HPC

Il calcolo ad alte prestazioni non è la soluzione migliore per tutti i problemi. Ecco alcune soluzioni alternative, che in alcuni casi potrebbero risultare più adeguate:

Gestione dei dati sensibili

Anche se può elaborare rapidamente grandi quantità di informazioni, l'HPC potrebbe non essere la scelta migliore per gestire le informazioni sensibili. Lo storage di dati nei sistemi HPC in modalità condivisa e batch pone sfide per i dati sensibili come quelli sanitari, finanziari o protetti da privacy.

Esistono metodi per elaborare in modo sicuro le informazioni protette su questi sistemi, ma spesso richiedono misure aggiuntive e possono avere impatto sulle operazioni esistenti.

Carichi di lavoro a basso volume

I sistemi HPC sono progettati per gestire grandi volumi di informazioni e calcoli complessi. Per i carichi di lavoro a basso volume, il tempo e gli sforzi necessari per imparare e utilizzare i cluster potrebbero non essere giustificati.

L'investimento nell'apprendimento della gestione di Linux, shell scripting e altre competenze per l'utilizzo dei cluster HPC potrebbe essere speso meglio altrove se il volume di lavoro è basso.

Carichi di lavoro seriali a basso volume e memoria

L’HPC non è una bacchetta magica che rende più veloce qualsiasi carico di lavoro. I flussi di lavoro eseguiti solo su un singolo core (seriale) e che non richiedono grandi quantità di memoria potrebbero essere più lenti nei computer ad alte prestazioni rispetto alla maggior parte dei computer desktop e notebook moderni.

Eseguendo un numero ridotto di processi seriali, è probabile che un normale computer li completi più rapidamente.

Formazione ed educazione

I cluster HPC universitari permettono di eseguire grandi carichi di lavoro computazionali, ma solitamente non sono utilizzati come servizio o aiuto alla formazione.

Anche se possono esistere eccezioni per la formazione specifica nel calcolo ad alte prestazioni (previo accordo con il personale), questi sistemi non sono solitamente destinati a fini educativi e di formazione generale.

Finalità illegittime o non legate alla ricerca

I cluster HPC sono sviluppati per facilitare i carichi di lavoro di ricerca legittimi. Chi fa un uso inappropriato delle risorse del cluster come mining di criptovalute, hosting di servizi Web, abuso del file storage per i file personali, accesso a file o software a cui l'utente non ha diritto o altri utilizzi non legittimi, potrebbe incorrere in indagini e azioni legali.

Anche la condivisione degli account non è consentita e qualsiasi utente o soggetto sorpreso a condividere gli account potrebbe incorrere in spiacevoli provvedimenti.

Innovazioni nell'HPC

Negli ultimi anni il calcolo ad alte prestazioni ha conosciuto innovazioni significative. Le soluzioni basate sul Cloud sono sempre più diffuse e offrono risorse scalabili ed economicamente vantaggiose per attività di calcolo intensivo. Questa tendenza contribuisce alla sua democratizzazione, rendendo questi potenti strumenti accessibili a un numero sempre crescente di utenti.

Il calcolo a esascala, capace di eseguire un exaflop (un miliardo di miliardi di calcoli al secondo), costituisce la prossima frontiera nel calcolo ad alte prestazioni.

Sebbene ancora nelle prime fasi di sviluppo, il quantum computing assicura di offrire miglioramenti di grande entità in termini di prestazioni rispetto ai computer tradizionali. I computer quantistici potrebbero offrire una soluzione a problemi attualmente irrisolvibili, aprendo nuove possibilità alle applicazioni HPC.

HPC in diversi settori

Come si applica, concretamente, il calcolo ad alte prestazioni? Ecco alcune implicazioni pratiche nei diversi settori.

Settori ad alta domanda

Il calcolo ad alte prestazioni svolge un ruolo significativo ovunque sia necessaria un'elevata capacità di calcolo: dalla sanità alle scienze biologiche passando per la produzione, l’energia e le previsioni meteorologiche. Questa soluzione implica l'implementazione di processori, server e sistemi potenti in grado di gestire grandi insiemi di informazioni, realizzare calcoli complessi ed eseguire attività con un utilizzo intensivo di dati in modo più efficiente.

Industria manifatturiera

Nel settore manifatturiero, l’HPC viene utilizzato per la risoluzione di problemi in un'ampia gamma di applicazioni. Aiuta a modernizzare le industrie legacy e migliorare i settori manifatturieri più recenti, come la produzione additiva. Il calcolo ad alte prestazioni ha dimostrato la sua capacità di ridurre i costi di fabbricazione e migliorare la produzione.

Media e intrattenimento

Nel settore di media e intrattenimento, l’HPC viene utilizzato per creare e diffondere contenuti in modo efficiente. È fondamentale per realizzare effetti visivi di alta qualità e immagini generate tramite computer. Le soluzioni HPC devono poter integrarsi con gli strumenti e le applicazioni esistenti e garantire l'efficienza in tutte le fasi dei flussi di lavoro.

Energia

Anche se non sono disponibili risultati di ricerca specifici per il settore dell'energia, è noto che l'HPC è ampiamente utilizzato in questo ambito per attività come la modellazione e la simulazione di riserve energetiche, l'ottimizzazione della distribuzione della rete elettrica e il miglioramento dell'efficienza energetica nei processi di produzione.

Sanità e scienze biologiche

L'HPC sta trasformando il settore della sanità e delle scienze biologiche, consentendo ai professionisti di elaborare i dati quasi in tempo reale e generare informazioni in grado di cambiare la vita dei pazienti. Questa soluzione supporta gli ambiti scientifici, dalla ricerca alle applicazioni industriali nel settore medico, permettendo ai ricercatori di eseguire in modo più rapido calcoli, simulazioni e analisi sempre più complessi.

Previsioni meteorologiche

L'HPC è cruciale nelle previsioni meteorologiche, dove viene utilizzato per elaborare grandi quantità di dati. Queste informazioni vengono utilizzate per eseguire simulazioni complesse e modelli che prevedono pattern ed eventi meteorologici. La velocità e la potenza computazionale di questi sistemi permettono di realizzare previsioni in modo rapido e preciso, fornendo informazioni preziose per la pianificazione e il processo decisionale in vari settori come agricoltura, energia e gestione di disastri.

Intraprendere un viaggio verso l'HPC

Per adottare l'HPC, è necessario iniziare valutando l'infrastruttura attuale e definendo chiaramente obiettivi, requisiti, vincoli e risultati previsti.

Questo implica la comprensione delle esigenze computazionali specifiche dell'azienda e dei tipi di carichi di lavoro che verranno eseguiti sul sistema. Dopo aver stabilito gli obiettivi e i requisiti, è il momento di scegliere il provider Cloud e gli strumenti più adatti per rispondere alle esigenze aziendali di calcolo ad alte prestazioni. Consigliamo di cercare risorse scalabili e servizi specializzati adatti ai carichi di lavoro HPC.

Inoltre, è fondamentale coinvolgere la direzione esecutiva nel processo decisionale per garantire un’azione coordinata a livello strategico e ottenere gli investimenti necessari. Le aziende dovrebbero prendere in considerazione anche le best practice per eseguire i carichi di lavoro, ad esempio evitare di sovraccaricare il sistema con troppi processi, utilizzare in modo efficiente lo spazio disco e ottimizzare il codice per raggiungere prestazioni superiori.

Le nostre soluzioni HPC

OVHcloud offre soluzioni di High Performance Computing (HPC) che forniscono capacità di calcolo rapide ed efficienti senza la necessità di costi anticipati. La nostra rete globale include 46 datacenter e 44 PoP ridondati in 140 Paesi, garantendo bassa latenza e una consegna rapida della capacità HPC quando necessario, per rispondere alle esigenze dei clienti, ad esempio in termini di Machine Learning ed elaborazione avanzata dei dati.

Mettiamo a disposizione un’ampia gamma di soluzioni HPC, tra cui hardware innovativo gestito da un team specializzato nell’innovazione di server dedicati e server GPU Cloud appositamente sviluppati per un utilizzo intensivo come per l’IA.

Le soluzioni di OVHcloud sono progettate per rispondere a numerose esigenze come video on demand, live streaming, gaming interattivo, esecuzione di simulazioni innovative, rivalutazione di modelli finanziari o analisi di dataset su larga scala. Offriamo la flessibilità di utilizzare l’HPC quando necessario, senza essere proprietario dell’infrastruttura.

OVHcloud e High Performance Computing (HPC)

Scegli il server dedicato più adatto alle tue applicazioni aziendali

Con OVHcloud puoi contare sulla nostra esperienza in tecnologia Bare Metal per ospitare siti Web, eseguire il deploy di infrastrutture ad alta resilienza e personalizzare le macchine in pochi click in base ai progetti.

Il tuo datacenter privato nel Cloud

Accelera la tua trasformazione digitale con le nostre soluzioni scalabili Hosted Private Cloud. I servizi di OVHcloud sono flessibili, innovativi e offrono una sicurezza ottimale dei dati, per permetterti di concentrarti sulla tua attività.

Soluzioni di rete

Le applicazioni e i loro componenti devono essere disponibili 24/7, tutto l'anno. Le soluzioni di OVHcloud offrono una risposta alle diverse esigenze di rete, indipendentemente dal tipo di connettività: privata, pubblica o on-premise. Le nostre reti private garantiscono una comunicazione sicura tra server e servizi. OVHcloud dispone inoltre della propria backbone, progettata per garantire un accesso rapido e affidabile alle applicazioni, sempre e ovunque. In questo modo l’utente mantiene sempre il controllo completo dei dati, senza eccezioni.