Cos’è l’analisi dei dati?

L’analisi dei dati è l’arte di trasformare i dati aziendali grezzi in conoscenze utilizzabili. Si tratta di un processo di data mining in più fasi che inizia con la raccolta, la pulizia e l'organizzazione di informazioni provenienti da diverse fonti. Lo step successivo consiste nell’analisi, in cui gli esperti utilizzano tecniche statistiche e algoritmi di Machine Learning per trovare modelli, correlazioni e tendenze nascoste all’interno dei dati.

Ma l’analisi dei dati non si limita al semplice calcolo dei numeri: l’obiettivo finale è raggiungibile. Le aziende si affidano all’analisi dei dati per prendere decisioni consapevoli, semplificare le operazioni e, in ultima analisi, favorire la crescita.

Che si tratti di prevedere il comportamento dei clienti, ottimizzare le campagne di marketing o identificare i potenziali rischi aziendali, l'analisi dei dati aiuta le aziende a esplorare le complessità del mondo moderno con fiducia e chiarezza. È la chiave per liberare tutto il potenziale delle informazioni in una società sempre più data driven.

Qual è la differenza tra Data Analytics e Data Science?

Sebbene l’analisi dei dati e la data science siano strettamente correlate e spesso utilizzate in modo intercambiabile, esistono importanti distinzioni tra di esse.

Data Analytics esamina i dati esistenti per ottenere informazioni e rispondere a domande specifiche. Utilizza metodi e strumenti statistici consolidati per analizzare i dati storici, identificare le tendenze ed estrarre modelli significativi. Data Analytics è finalizzato a fornire suggerimenti pratici per migliorare le operazioni aziendali, il processo decisionale e le prestazioni generali.

D'altra parte, la scienza dei dati è un campo più ampio che include l'analisi dei dati ma va oltre. I data scientist analizzano i dati esistenti e sviluppano nuovi algoritmi, modelli e strumenti per prevedere i risultati futuri e risolvere problemi complessi.

Perché l’analisi dei dati è importante?

L’analisi dei dati è fondamentale perché trasforma i dati aziendali grezzi in informazioni fruibili, che agiscono come una piattaforma concreta per il processo decisionale. Aiuta le aziende a comprendere i propri clienti, ottimizzare le operazioni, identificare le tendenze di mercato e gestire i rischi. Individuando modelli nascosti e fornendo una prospettiva basata sui dati, l'analisi dei dati aiuta le aziende a fare scelte strategiche, migliorare l'efficienza e raggiungere una crescita sostenibile nel panorama competitivo odierno.

Cos’è il Big Data Analytics?

Il Big Data Analytics è un ramo specializzato del business data analytics che si occupa di dataset complessi e di grandi dimensioni, conosciuti come Big Data . Questi dataset sono così numerosi e diversificati che i tradizionali strumenti di elaborazione e analisi dei dati sono inadeguati.

Bisogna notare che i Big Data provengono da diverse fonti, tra cui social media, sensori, transazioni finanziarie e ricerca scientifica. Spesso include dati non strutturati come testi, immagini e video, rendendo difficile la gestione e l'analisi.

Come funziona il Big Data Analytics?

Il Big Data Analytics è un processo in più fasi che include la raccolta di grandi quantità di dati grezzi da diverse fonti, l'elaborazione in un formato utilizzabile e l'applicazione di tecniche di analisi avanzate per aiutare a scoprire modelli, analisi e tendenze di valore. Queste informazioni consentono alle aziende di prendere decisioni consapevoli, ottimizzare le operazioni e promuovere l'innovazione.

Raccolta dei dati

Il primo passo nell’analisi dei Big Data è raccogliere dati grezzi da diverse fonti. Tali origini possono includere dati strutturati organizzati in database, fogli di calcolo o record finanziari, dati non strutturati che non si adattano perfettamente a modelli predefiniti, ad esempio post su social media, messaggi di posta elettronica, video o dati di sensori e dati semistrutturati con alcuni elementi organizzativi, ad esempio file XML o JSON.

Processi ETL: Estrazione, trasformazione, caricamento

L’approccio tradizionale al trattamento dei dati aziendali nell’analisi dei Big Data è il processo ETL: I dati vengono estratti da vari sistemi di origine, spesso utilizzando tecniche complesse di integrazione dei dati per gestire formati e strutture diversi.

I dati estratti vengono quindi puliti, standardizzati e convertiti in un formato coerente adatto all'analisi. Questo può comportare la rimozione dei duplicati, la correzione degli errori e l'aggregazione dei dati. Infine, i dati trasformati vengono caricati in un data warehouse o in un lago, organizzati e archiviati per essere analizzati ulteriormente.

Processi ELT: Estrazione, caricamento, trasformazione

Un approccio alternativo che sta diventando sempre più popolare è il processo ELT: Analogamente a ETL, i dati vengono estratti dai sistemi di origine. Tuttavia, i dati grezzi vengono caricati direttamente in un data lake senza alcuna trasformazione significativa, consentendo una maggiore flessibilità e scalabilità. La trasformazione dei dati avviene all’interno del data lake utilizzando strumenti e tecnologie specializzati. come la pulizia, l’arricchimento e la preparazione dei dati per attività di analisi specifiche.

Storage dei dati

Lo storage dei dati è un aspetto fondamentale dei moderni sistemi informatici aziendali, in quanto include i metodi e le tecnologie utilizzati per conservare le informazioni digitali per un utilizzo immediato e futuro. Si tratta di una componente essenziale della gestione dei dati, in quanto garantisce che le informazioni preziose rimangano accessibili e possano essere elaborate in modo efficiente.

Data Lake vs. Data warehouse Analisi comparativa

I data lake e i data warehouse sono due paradigmi di storage dei dati principali che si adattano alle esigenze specifiche di un'azienda. Capire le loro differenze è fondamentale per prendere decisioni consapevoli sulle strategie di gestione dei dati.

I data lake sono enormi repository in cui vengono archiviati dati non elaborati e non elaborati provenienti da diverse fonti in formati nativi. Offrono una soluzione flessibile e scalabile per ospitare grandi volumi di dati strutturati, semistrutturati e non strutturati. I data lake costituiscono un hub centralizzato per data scientist, analisti di carriera e altri utenti per esplorare, testare e scoprire informazioni preziose senza i vincoli di schemi predefiniti. Tuttavia, la mancanza di struttura può rendere l'individuazione e l'analisi dei dati un'operazione lunga e laboriosa.

I data warehouse, invece, sono repository strutturati progettati per archiviare i dati elaborati e organizzati per specifici scopi analitici. Spesso si basano su un approccio schema-on-write, in cui i dati vengono trasformati e puliti prima di essere caricati nel magazzino.

Elaborazione dei dati

L’elaborazione dei dati è la trasformazione dei dati grezzi in informazioni significative e utilizzabili. che prevede una serie di operazioni, tra cui la raccolta, l'organizzazione, la pulizia, la trasformazione e l'analisi dei dati per ottenere informazioni utili.

Si tratta di un processo fondamentale da utilizzare in vari settori, tra cui quello commerciale, scientifico e tecnologico, in quanto consente di prendere decisioni, supporta la ricerca e stimola l'innovazione. Esistono diversi metodi di elaborazione, a seconda dei requisiti e dei vincoli specifici dell'applicazione.

elaborazione centralizzata

Nell’elaborazione centralizzata, tutte le attività di elaborazione dei dati vengono eseguite su un unico computer o server centrale. Questa architettura offre semplicità e semplicità di gestione, in quanto tutti i dati e le risorse di elaborazione sono localizzati in un'unica posizione.

Si adatta a scenari aziendali in cui i volumi di dati sono moderati e l'elaborazione in tempo reale non è un problema primario. Tuttavia, i sistemi centralizzati possono trovarsi di fronte a limitazioni di scalabilità e diventare un singolo punto di errore se non adeguatamente gestiti.

elaborazione distribuita

L'elaborazione distribuita implica la distribuzione delle attività di elaborazione dei dati su più computer o nodi interconnessi. Questo approccio offre maggiore scalabilità, tolleranza ai guasti e prestazioni superiori rispetto all'elaborazione centralizzata.

Ciascun nodo del sistema distribuito può elaborare una parte dei dati in parallelo, accelerando così i tempi di elaborazione. È particolarmente indicato per la gestione di grandi volumi di dati e applicazioni che richiedono alta disponibilità e reattività.

Elaborazione batch

L'elaborazione batch è un metodo in cui i dati vengono raccolti ed elaborati in batch a intervalli pianificati. Questo approccio è efficace per le attività che non richiedono risultati immediati e che possono essere eseguite offline.

Esempi di elaborazione batch includono l'elaborazione del ciclo paghe, la generazione di report e i backup dei dati. L'elaborazione in batch consente di ottimizzare l'utilizzo delle risorse ed è conveniente per l'elaborazione di dataset di grandi dimensioni.

Elaborazione in tempo reale

L'elaborazione in tempo reale, o stream, consiste nell'elaborazione dei dati quando questi arrivano in un flusso continuo. Questo approccio è essenziale per le applicazioni che richiedono risposte immediate a eventi o modifiche dei dati.

Ne sono un esempio il rilevamento di frodi, l'analisi del mercato azionario e l'elaborazione dei dati dei sensori. L’elaborazione in tempo reale richiede un’infrastruttura reattiva e algoritmi specializzati per gestire il flusso continuo dei dati.

Pulizia dati

La pulizia dei dati consiste nell'identificazione e nella correzione o rimozione di errori, incoerenze e inesattezze dei dataset.

Si tratta di un passo fondamentale in qualsiasi progetto basato sui dati, in quanto garantisce la qualità e l’affidabilità dei dati utilizzati per l’analisi e il processo decisionale. La pulizia dei dati implica diverse attività, ad esempio la gestione dei valori mancanti, la correzione delle incoerenze, la rimozione dei duplicati e la standardizzazione dei formati.

Analisi dei dati

L'analisi dei dati ispeziona, pulisce, trasforma e modella i dati per individuare informazioni utili, trarre conclusioni e supportare il processo decisionale. Esistono diversi tipi di analisi dei dati, ognuna delle quali ha uno scopo specifico:

Analisi descrittiva

L’analisi descrittiva è la forma più basilare di analisi dei dati. Si concentra sulla sintesi e la descrizione di ciò che è successo in passato.

Questo tipo di analisi utilizza tecniche come la media, la mediana, la modalità e gli strumenti di visualizzazione e deviazione standard come grafici e diagrammi per presentare i dati in modo significativo. L'analisi descrittiva risponde alla domanda "Cos'è successo?" e aiuta a identificare tendenze e modelli nei dati storici.

Diagnostic Analytics

L'analisi diagnostica va oltre l'analisi descrittiva, cercando di capire perché è successo qualcosa. Questo metodo implica l'analisi approfondita dei dati, l'esplorazione delle relazioni tra le variabili e l'identificazione delle cause principali dei problemi o dei successi. Diagnostic Analytics risponde alla domanda "Perché?" e aiuta a scoprire le intuizioni e le dipendenze nascoste all'interno dei dati.

analisi predittiva

L’analisi predittiva utilizza dati storici e algoritmi statistici per prevedere i risultati futuri. Identifica modelli e tendenze nei dati passati e li estrae nel futuro. L'analisi predittiva risponde alla domanda "Che cosa è probabile che accada?" ed è utilizzata in varie applicazioni, come la previsione delle variazioni dei clienti, le previsioni di vendita e la valutazione dei rischi.

Analisi prescrittive

L’analisi prescrittiva è la forma più avanzata di analisi dei dati. Prevede ciò che potrebbe accadere e raccomanda azioni per contribuire a raggiungere i risultati previsti.

Questo tipo di analisi utilizza tecniche di ottimizzazione e algoritmi di Machine Learning per suggerire la migliore strategia di azione. L'analisi prescrittiva risponde alla domanda "Cosa dovremmo fare?" ed è utilizzata in aree come l'ottimizzazione della supply chain, l'allocazione delle risorse e il marketing personalizzato.

Applicazioni di Data Analytics in diversi settori

L’analisi dei dati è diventata una colonna portante in diversi settori, rivoluzionando le operazioni e i processi decisionali. Nel settore sanitario, viene utilizzato per analizzare le cartelle cliniche dei pazienti, identificare gli schemi che potrebbero portare a una rilevazione più precoce della malattia, piani terapeutici personalizzati e persino prevedere i focolai epidemici.

Nel frattempo, nel settore finanziario, l'analisi dei dati aiuta a rilevare le frodi, valutare i rischi, eseguire trading algoritmici e analizzare il comportamento dei clienti per ottimizzare le strategie di investimento e personalizzare i prodotti finanziari.

Il settore del retail utilizza l'analisi dei dati per ottenere informazioni utili sulle preferenze dei consumatori e sulle abitudini di acquisto. I retailer possono personalizzare i suggerimenti sui prodotti, ottimizzare la gestione dell'inventario e creare campagne di marketing mirate analizzando i dati delle transazioni. I produttori utilizzano l'analisi dei dati per migliorare l'efficienza della produzione, prevedere i guasti delle apparecchiature e ottimizzare le supply chain, riducendo i costi e migliorando la qualità del prodotto.

Anche in settori come il trasporto e la logistica, l'analisi dei dati svolge un ruolo fondamentale nell'ottimizzazione delle rotte, nella previsione dei ritardi e nell'aumento dell'efficienza del carburante. Nel settore energetico, aiuta a monitorare i modelli di consumo energetico, prevedere le fluttuazioni della domanda e ottimizzare la distribuzione delle risorse.

Quali sono le diverse capacità di analisi dei dati?

Elaborazione del linguaggio naturale

Le abilità del Natural Language Processing (NLP) esplorano l'intricato mondo del linguaggio umano, consentendo alle macchine di aiutare a comprendere, interpretare e generare testo che rispecchia la comunicazione umana.

Questa potente tecnica trova applicazioni nell'analisi dei sentimenti, dove analizza le emozioni e le opinioni espresse nel testo; la traduzione linguistica, che abbatte le barriere linguistiche e facilita la comunicazione globale; e lo sviluppo di chatbot, che crea assistenti virtuali in grado di avviare conversazioni naturali.

Identificazione delle anomalie mediante l'analisi dei valori anomali

Le capacità di analisi dei valori anomali sono fondamentali per identificare i punti di dati che si discostano in modo significativo dalla norma. Queste anomalie possono indicare errori di immissione dei dati, attività fraudolente o eventi rari con implicazioni significative. Individuando i valori anomali, possiamo attivare interventi tempestivi, analizzare potenziali problemi e garantire la qualità dei dati.

Analisi di coorte: Segmentazione dei dati per maggiore chiarezza

L’analisi di coorte consiste nel segmentare i dati in gruppi distinti sulla base di caratteristiche o esperienze condivise. Questa tecnica illumina il comportamento del cliente rivelando i modelli di comportamento di acquisto, i tassi di variazione e i livelli di coinvolgimento. Comprendendo le dinamiche di coorte, le aziende possono personalizzare le strategie in base a segmenti di clienti specifici e ottimizzare le attività di marketing.

Sblocco di informazioni dettagliate con il data mining di testo

Le competenze di estrazione del testo sono strettamente correlate, il che implica l'estrazione di modelli e informazioni significativi da dati di testo non strutturati. Queste competenze risultano preziose per attività come la modellazione di argomenti, in cui vengono individuati temi nascosti in grandi quantità di testo, la classificazione dei documenti, l'organizzazione e la categorizzazione automatica dei documenti utilizzati in base al loro contenuto e il recupero delle informazioni, consentendo la ricerca e l'estrazione efficiente delle informazioni rilevanti dai repository di testo.

Analisi di regressione: prevedere e comprendere le tendenze

Le capacità di analisi della regressione si focalizzano sulla comprensione della relazione tra le variabili e sulla previsione dei risultati futuri. Stabilendo modelli matematici, questa tecnica consente agli analisti di prevedere gli andamenti delle vendite, stimare i valori delle proprietà e valutare l'impatto delle campagne di marketing. La comprensione di queste relazioni consente un processo decisionale basato sui dati.

Analisi dello scenario tramite Simulazioni di Monte Carlo

Le simulazioni di Monte Carlo utilizzano un campionamento casuale per modellare e analizzare la probabilità di risultati diversi in diversi scenari. In ambito finanziario, le BCN valutano i rischi di investimento e i risultati del portafoglio. Nella gestione dei progetti, stimano le tempistiche e i costi del progetto. Simulando l’incertezza, le simulazioni di Monte Carlo permettono di prendere decisioni consapevoli in situazioni complesse.

Analisi dei dati dei sensori per una comprensione più approfondita

Le capacità di analisi dei dati dei sensori sbloccano le conoscenze esaminando i dati raccolti da vari sensori. Nel settore sanitario, aiuta il monitoraggio dei pazienti e la rilevazione delle malattie. Nel settore manifatturiero, ottimizza i processi di produzione e prevede i guasti delle apparecchiature.

Nel monitoraggio ambientale, queste competenze tengono traccia dei livelli di inquinamento e dei modelli climatici. Analizzando i dati dei sensori possiamo ottenere informazioni più approfondite sul mondo che ci circonda e prendere decisioni consapevoli.

Analisi dei dati complessi

Le abilità di analisi dei fattori esaminano la struttura sottostante dei dati complessi identificando variabili latenti o fattori che spiegano le correlazioni osservate tra le variabili. Nelle ricerche di mercato, l'analisi dei fattori aiuta a identificare le preferenze dei consumatori e a segmentare i mercati. In psicologia, scopre i tratti della personalità e le dimensioni. Semplificando i dati complessi, l'analisi dei fattori facilita l'interpretazione e la comprensione.

Decifrare pattern con l'analisi Time Series

L’analisi delle serie temporali decifra gli schemi e le tendenze dei dati raccolti nel tempo. Esaminando le dipendenze temporali e le fluttuazioni dei dati, questa tecnica consente una previsione accurata delle vendite, il rilevamento delle anomalie nei log di sistema e l'identificazione delle relazioni causali nei dati economici. Comprendere gli schemi passato e presente ci permette di prevedere il futuro e di prendere decisioni proattive.

Strumenti di Data Analytics

Gli strumenti di Data Analytics sono programmi software e applicazioni che funzionano come soluzioni di Data Analytics per raccogliere, elaborare, analizzare e visualizzare grandi volumi di dati. Sono fondamentali per trasformare i dati grezzi in informazioni fruibili che guidano un processo decisionale informato. Questi strumenti consentono alle aziende di scoprire modelli nascosti, identificare tendenze e prevedere risultati futuri, migliorando l'efficienza operativa, aumentando la redditività e ottenendo un vantaggio competitivo sul mercato.

Il ruolo dell’analisi dei dati nel processo decisionale aziendale

L’analisi dei dati è fondamentale per fornire alle aziende gli strumenti necessari per prendere decisioni consapevoli, ottimizzare le operazioni e promuovere l’innovazione. Sfruttando la potenza dei dati, le aziende possono ottenere informazioni preziose sul comportamento dei clienti, sulle tendenze di mercato e altro ancora.

Gli analisti dei dati sulle carriere interpretano il panorama dei dati. in grado di raccogliere, elaborare e analizzare grandi volumi di informazioni, trasformando i dati grezzi in informazioni fruibili. Gli analisti di carriera utilizzano una varietà di tecniche, dall'analisi statistica alla visualizzazione dei dati, per scoprire tendenze, modelli e correlazioni che possono informare il processo decisionale strategico. Il loro lavoro è essenziale in un mondo basato sui dati, consentendo alle aziende di comprendere meglio le operazioni, i clienti e i mercati.

Il ruolo dell'analista si estende oltre l'esecuzione di calcoli. Gli analisti sono comunicatori efficaci, capaci di tradurre risultati complessi in rapporti e presentazioni chiari e concisi. Spesso collaborano con gli stakeholder all'interno dell'organizzazione, assicurando che le informazioni basate sui dati non solo siano comprese ma anche implementate. Sia che si tratti di ottimizzare i processi aziendali, aiutare a identificare nuove opportunità o mitigare i rischi, gli analisti svolgono un ruolo fondamentale nell’utilizzo dei dati per raggiungere il successo.

Migliorare La Comprensione Del Cliente Tramite L'Analisi Dei Dati

Data Analytics consente alle aziende di approfondire il comportamento, le preferenze e i modelli di acquisto dei clienti. Analizzando i dati dei clienti, le aziende possono identificare i trend, segmentare il target di riferimento e personalizzare le attività di marketing. Questa migliore comprensione dei clienti consente di offrire prodotti su misura, migliorare il servizio di assistenza e aumentare la soddisfazione dei clienti.

Guida allo sviluppo di prodotti con informazioni dettagliate ottenute da Data Analytics

Data Analytics fornisce preziose informazioni sulle preferenze del cliente, sui punti critici e sulle tendenze emergenti. Analizzando i dati sull'utilizzo dei prodotti, i feedback e le ricerche di mercato, le aziende possono identificare le opportunità di innovazione e miglioramento dei prodotti. Lo sviluppo di prodotti basato sui dati garantisce che i nuovi prodotti e le nuove funzionalità siano in linea con le esigenze dei clienti, con conseguente maggiore adozione e fidelizzazione dei clienti.

Creare strategie di marketing efficaci con Data Analytics

Le aziende possono ottimizzare le proprie strategie di marketing grazie all’analisi dei dati, identificando i canali, i messaggi e le campagne più efficaci. Analizzando i dati delle campagne di marketing, le aziende possono misurare il ritorno sull'investimento (ROI) e affinare il proprio approccio. Il marketing basato sui dati garantisce un'allocazione efficiente delle risorse e campagne rivolte al pubblico giusto, massimizzando l'impatto e ottenendo risultati tangibili.

Semplificazione della scalabilità delle operazioni di dati tramite Data Analytics

Man mano che le aziende crescono, aumenta anche il volume e la complessità dei dati. Data Analytics consente alle aziende di scalare le operazioni relative ai dati implementando procedure efficienti di gestione, automatizzando l'elaborazione dei dati e garantendo la qualità dei dati stessi. Le operazioni scalabili consentono alle aziende di trarre il massimo valore dalle proprie risorse di dati e di supportare processi decisionali basati sui dati all'interno dell'organizzazione.

Migliorare l'efficienza operativa tramite Data Analytics

L'analisi dei dati può migliorare in modo significativo l'efficienza operativa identificando colli di bottiglia, ottimizzando i processi e migliorando l'allocazione delle risorse. Analizzando i dati operativi, le aziende possono identificare le aree di miglioramento, semplificare i flussi di lavoro e ridurre i costi. Le informazioni basate sui dati consentono alle aziende di prendere decisioni basate sui dati, in modo da garantire l'eccellenza operativa e migliorare la produttività complessiva.

OVHcloud e Data Analytics

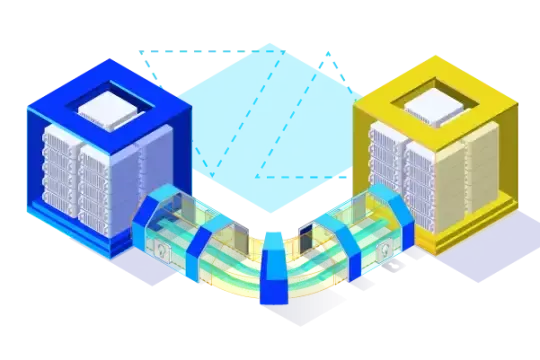

OVHcloud fornisce una suite completa di infrastrutture Cloud e soluzioni di Data Analytics per aiutare le aziende a intraprendere il percorso verso i dati, e tutti coloro che sono interessati a diventare Data Analyst nella loro carriera.

Dalle risorse informatiche scalabili alle piattaforme di dati gestite, OVHcloud offre strumenti e competenze per aiutare le aziende a raccogliere, archiviare, elaborare e analizzare i propri dati in modo efficace. Grazie all’infrastruttura affidabile e sicura di OVHcloud, le aziende possono concentrarsi sull’estrazione di informazioni preziose dai propri dati e sull’innovazione data driven.