Data Processing Engine

Data Processing Engine

OVHcloud Data Platform – usługa integracji i transformacji danych, która automatyzuje procesy ETL/ELT w środowisku produkcyjnym.

Automatyzuj przetwarzanie i transformację danych

Przetwarzanie

Stosuj przetwarzanie wsadowe – wyodrębniaj, przekształcaj i przesyłaj dane z różnych źródeł do ich docelowych lokalizacji.

Automatyzacja

Twórz przepływy pracy za pomocą interfejsu low-code i automatyzuj zadania.

Rozwój

Koduj i uruchamiaj dowolny niestandardowy skrypt Python lub PySpark i korzystaj z kompletnego zestawu SDK z wieloma konektorami.

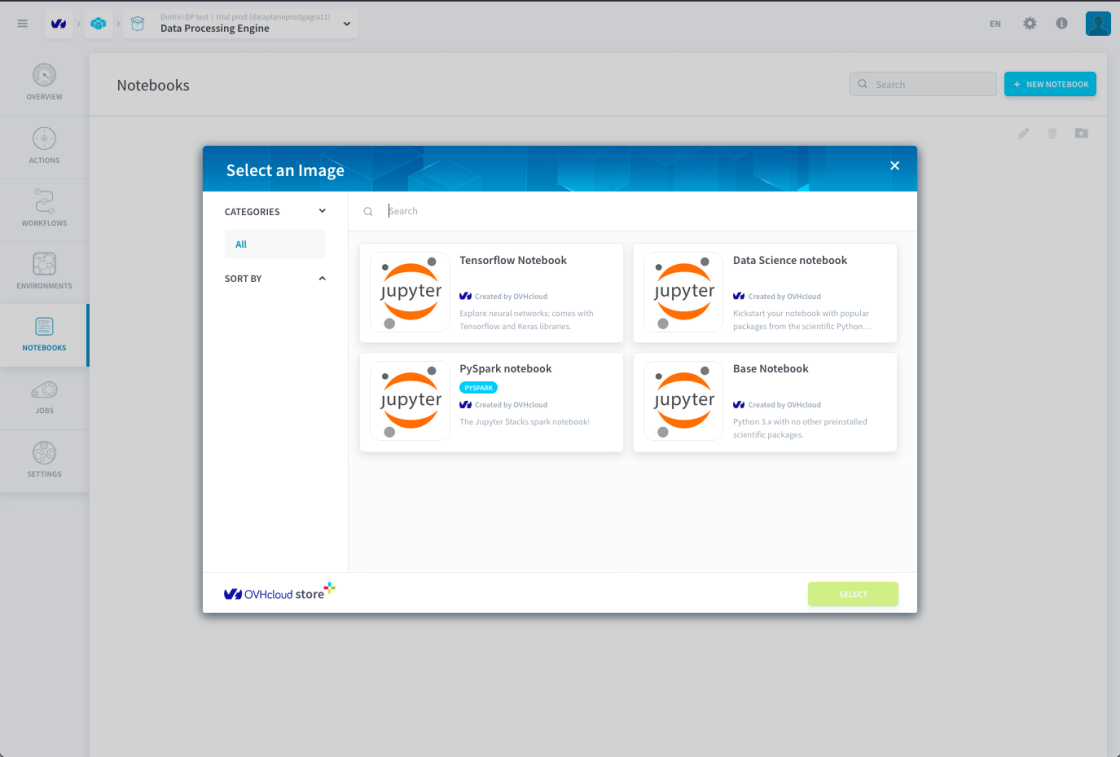

Praca z kodem

Twórz, uruchamiaj i udostępniaj kod w środowiskach Jupyter Notebook.

Demo

Przyspiesz Twoje projekty Data & Analytics

Chcesz wdrażać, zarządzać i skalować swoje projekty i aplikacje Data bardzo szybko i prosto? Dzięki zintegrowanej, bezpiecznej platformie do pracy zespołowej analitycy biznesowi, inżynierowie danych oraz front-end developerzy mogą zwiększyć swoją produktywność. Data Platform od OVHcloud, oparta na technologiach open source, takich jak Apache Spark, Iceberg czy Trino, zapewnia dostęp, w ramach tego samego środowiska, do usług integracji danych, przechowywania i odzyskiwania danych.

Vimeo umieszcza w odtwarzanych przez Ciebie filmach znaczniki, które umożliwiają późniejsze wyświetlanie reklam targetowanych w oparciu o Twoją historię przeglądania.

Aby obejrzeć film, musisz zaakceptować politykę „Udostępnianie plików cookie na platformach stron trzecich” w naszym Centrum Prywatności. Zgodę możesz wycofać w dowolnym momencie.

Aby uzyskać więcej informacji, sprawdź politykę cookies Vimeo oraz politykę cookies OVHcloud.

Zachowaj kontrolę nad danymi

Twórz i personalizuj zadania przetwarzania

Połącz się z dowolnym źródłem danych. Obszerny katalog predefiniowanych szablonów zadań umożliwia tworzenie operacji ekstrakcji, ładowania, agregacji i czyszczenia danych oraz aktualizacji metadanych. Koduj i uruchamiaj dowolny niestandardowy skrypt Python lub PySpark i korzystaj z kompletnego zestawu SDK z ponad 40 konektorami. Jeśli dysponujesz już skryptami do przetwarzania danych w języku Python, zaimportuj je, aby je scentralizować i zorkiestrować w Data Platform.

Zarządzać pakietami i zależnościami za pomocą spersonalizowanych działań, w tym własnych bibliotek, które możesz ponownie wykorzystać w różnych projektach. Data Processing Engine jest dostarczany z dwoma systemami kontroli wersji, co zapewnia, że obciążenia krytyczne w środowisku produkcyjnym nigdy nie będą narażone na zakłócenia. Kontrola wersji Data Platform pozwala na śledzenie skalowalności wersji i synchronizację z dowolnym zewnętrznym repozytorium Git.

Definiuj i orkiestruj przepływy pracy

W prosty sposób definiuj, ustalaj kolejność i planuj zadania oraz zarządzanie zasobami. Skaluj je, używając workerów, które w razie potrzeby możesz kontrolować. Intuicyjny interfejs z funkcją „przeciągnij i upuść” pozwala na wizualizację i uruchamianie projektów w chmurze. Nie musisz przy tym posiadać zaawansowanych kompetencji technicznych ani doświadczenia w zarządzaniu infrastrukturą cloud. Zautomatyzuj wykonywanie zadań, w tym zadań CRON.

Uruchamiaj i skaluj procesy przetwarzania danych w chmurze

Uruchamiaj operacje i pełne przepływy pracy jako zadania za pomocą jednego wywołania API. Data Processing Engine integruje dwa silniki: silnik Pandas (w języku Python 3) zoptymalizowany pod kątem mniejszych zadań przetwarzania danych oraz silnik Spark (w PySpark) do intensywnych obciążeń.

Skaluj zadania w poziomie i w pionie i przyspieszaj ich realizację dzięki zasobom obliczeniowym OVHcloud. Wykonuj zadania równoległe, korzystając z narzędzi do segmentacji. Używaj opcji perymetrycznych i włączaj lub wykluczaj punkty danych, które znajdują się poza określonym obszarem.

Apache Spark™ wraz z logo jest znakiem towarowym firmy Apache Software Foundation. OVH SAS i jej spółki zależne nie mają powiązań z Apache Software Foundation ani nie są przez nią wspierane.

Uruchamiaj analizy danych bezpośrednio w notebookach Jupyter

Notebooki zintegrowane z OVHcloud Data Platform zapewniają gotowe środowisko Jupyter z wstępnie zainstalowanymi bibliotekami data science, które przyspieszają analizę danych.

Umożliwiają wstępne przetwarzanie z użyciem metod statystycznych i tworzenie interaktywnych wizualizacji w środowisku współdzielonym, przy zachowaniu pełnej integracji z pozostałą częścią projektu. Dzięki natywnej integracji z Lakehouse Manager i SDK możesz łatwo odczytywać i zapisywać dane, a następnie uruchamiać je w Data Processing Engine, co pozwala płynnie przejść od etapu analizy do wdrożenia operacyjnego.

Monitoruj wykonywanie i wydajność zadań

Przeglądaj szczegółowe raporty dotyczące ukończonych zadań, w tym wykorzystania CPU i RAM workerów w określonym czasie, oraz powiązane logi. Testuj i weryfikuj zadania, optymalizuj zużycie zasobów, używając punktów kontrolnych w przepływach pracy.

Korzystaj z Control Center Data Platform i alertów, aby otrzymywać powiadomienia o ukończeniu lub niepowodzeniu zadań, czasie ich trwania i wykorzystaniu RAM. Kontroluj precyzyjnie dostępy za pomocą narzędzia IAM (Identity Access Manager) zawartego w Data Platform.