O que é a Data Analytics?

A Data Analytics é a arte de transformar dados brutos da empresa em conhecimentos práticos. Trata-se de um processo de datamining em várias etapas que começa com a recolha, limpeza e organização de informação a partir de várias fontes. O próximo passo é a análise, onde os especialistas empregam técnicas estatísticas e algoritmos de machine learning para encontrar padrões, correlações e tendências ocultas dentro dos dados.

Mas a análise de dados é mais do que simples cálculos numéricos: existe um objetivo final. As organizações contam com a análise de dados para tomar decisões informadas, simplificar operações e, em última análise, impulsionar o crescimento.

Quer seja para prever o comportamento dos clientes, otimizar as campanhas de marketing ou identificar potenciais riscos comerciais, a Data Analytics permite às organizações navegar pelas complexidades do mundo moderno com confiança e clareza. É a chave para libertar todo o potencial da informação numa sociedade cada vez mais orientada para os dados.

Qual é a diferença entre a análise de dados e a data science?

Embora a análise de dados e a ciência de dados estejam intimamente relacionadas e sejam frequentemente usadas de forma intercambiável, há distinções essenciais entre elas.

A Data Analytics examina os dados existentes para ajudar a obter informações e responder a perguntas específicas. Utiliza métodos e ferramentas estatísticos estabelecidos para analisar dados históricos, identificar tendências e extrair padrões com significado. A Data Analytics tem como objetivo fornecer recomendações práticas para melhorar as operações comerciais, a tomada de decisões e o desempenho geral.

Por outro lado, a data science é um campo mais amplo que engloba a data analytics, mas vai além. Os data scientists analisam dados existentes e desenvolvem novos algoritmos, modelos e ferramentas para ajudar a prever resultados futuros e resolver problemas complexos.

Porque é que a Data Analytics é importante?

A análise de dados é vital porque transforma dados brutos de empresas em informações práticas, que funcionam como uma plataforma concreta para a tomada de decisões. Ajuda as empresas a compreender os seus clientes, a otimizar as operações, a identificar tendências de mercado e a gerir os riscos. Ao descobrir padrões ocultos e ao fornecer uma perspetiva orientada por dados, a análise de dados permite que as organizações façam escolhas estratégicas, melhorem a eficiência e alcancem um crescimento sustentável no cenário competitivo atual.

O que é a big data analytics?

Big Data Analytics é um ramo especializado da análise de dados de empresas que lida com conjuntos de dados extremamente grandes e complexos, conhecidos como Big Data. Estes conjuntos de dados são tão massivos e diversificados que as ferramentas tradicionais de tratamento e análise de dados não são adequadas.

É importante notar que o big data tem origem em várias fontes, como as redes sociais, os sensores, as transações financeiras e a investigação científica. Muitas vezes, inclui dados não estruturados, como textos, imagens e vídeos, o que dificulta a sua gestão e análise.

Como funciona a análise do big data?

Big Data Analytics é um processo em várias etapas que envolve a recolha de grandes quantidades de dados brutos provenientes de diferentes fontes, o seu processamento num formato utilizável e a aplicação de técnicas de análise avançadas para ajudar a descobrir padrões, informações e tendências valiosos. Estas informações permitem às empresas tomar decisões informadas, otimizar as operações e fomentar a inovação.

Recolha de dados

O primeiro passo da análise de big data consiste em recolher dados brutos de diversas fontes. Essas fontes podem incluir dados estruturados organizados em bancos de dados, planilhas ou registos financeiros; dados não estruturados que não se encaixam perfeitamente em modelos predefinidos, como postagens em redes sociais, e-mails, vídeos ou dados de sensores; e dados semiestruturados com alguns elementos organizacionais, como arquivos XML ou JSON.

Processos ETL: Extração, Transformação, Carregamento

A abordagem tradicional para o processamento de dados empresariais na análise de big data é o processo ETL: Os dados são extraídos de vários sistemas de origem, muitas vezes envolvendo técnicas complexas de integração de dados para lidar com diferentes formatos e estruturas.

Os dados extraídos são então limpos, normalizados e convertidos num formato consistente e adequado a análise. Isso pode envolver a remoção de duplicatas, correção de erros e agregação de dados. Por fim, os dados transformados são carregados num armazém de dados ou lago, organizados e armazenados para análise posterior.

Processos ELT: Extração, Carregamento, Transformação

Uma abordagem alternativa que ganha popularidade é o processo ELT: Semelhante ao ETL, os dados são extraídos dos sistemas de origem. No entanto, os dados brutos são carregados diretamente num lago de dados sem transformação significativa, o que permite uma maior flexibilidade e escalabilidade. A transformação dos dados ocorre dentro do lago de dados, utilizando ferramentas e tecnologias especializadas. Pode incluir a limpeza, o enriquecimento e a preparação de dados para tarefas analíticas específicas.

Armazenamento dos dados

O armazenamento de dados é um aspeto fundamental da computação empresarial moderna, englobando os métodos e tecnologias utilizados para ajudar a reter informações digitais para utilização imediata e futura. É uma componente essencial da gestão de dados, que garante que as informações valiosas permanecem acessíveis e podem ser tratadas com eficiência.

Data Lakes vs. Data warehouses Uma Análise Comparativa

Os data lakes e os repositórios de dados são dois paradigmas proeminentes de armazenamento de dados que respondem às diferentes necessidades das organizações. Compreender as suas diferenças é fundamental para tomar decisões informadas sobre estratégias de gestão de dados.

Os data lakes são vastos repositórios que armazenam em formatos nativos dados brutos não processados de diversas fontes. oferecem uma solução flexível e escalável para acomodar grandes volumes de dados estruturados, semiestruturados e não estruturados. Os data lakes servem como um centro centralizado para cientistas de dados, analistas de carreira e outros utilizadores, de modo a ajudar a explorar, experimentar e descobrir informações valiosas sem as restrições de esquemas predefinidos. No entanto, a falta de estrutura pode tornar a descoberta e a análise de dados morosas.

Os repositórios de dados, por outro lado, são repositórios estruturados concebidos para armazenar dados processados e organizados para fins analíticos específicos. Por norma, utilizam uma abordagem schema-on-write, o que significa que os dados são transformados e limpos antes de serem carregados no armazém.

Processamento de dados

O processamento de dados consiste na transformação de dados brutos em informações úteis e utilizáveis. Trata-se de uma série de operações, tais como a recolha, organização, limpeza, transformação e análise de dados, para ajudar a extrair informações valiosas.

Este processo é fundamental em vários domínios, incluindo as empresas, a ciência e a tecnologia, uma vez que permite a tomada de decisões, apoia a investigação e promove a inovação. São utilizados diferentes métodos de processamento em função dos requisitos específicos e das restrições da aplicação.

Tratamento centralizado

No processamento centralizado, todas as tarefas de processamento de dados são executadas num único computador ou servidor central. Esta arquitetura oferece simplicidade e facilidade de gestão, uma vez que todos os dados e recursos de processamento estão localizados no mesmo local.

É adaptado a cenários empresariais em que os volumes de dados são moderados e o processamento em tempo real não é a principal preocupação. No entanto, os sistemas centralizados podem enfrentar limitações de escalabilidade e tornar-se um ponto único de falha se não forem geridos adequadamente.

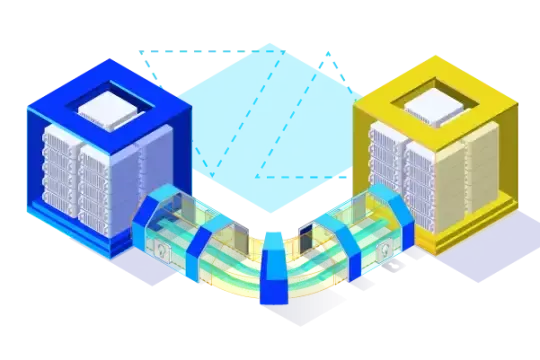

Processamento distribuído

O processamento distribuído envolve a distribuição de tarefas de processamento de dados por vários computadores ou nós interligados. Esta abordagem oferece uma maior escalabilidade, tolerância a falhas e um desempenho melhorado em comparação com o processamento centralizado.

Cada nó do sistema distribuído pode processar uma parte dos dados em paralelo, o que possibilita tempos de processamento mais rápidos. É adequada para lidar com grandes volumes de dados e aplicações que exijam alta disponibilidade e reatividade.

Processamento de batch

O tratamento por lotes é um método em que os dados são recolhidos e tratados em lotes a intervalos regulares. Esta abordagem é eficaz para as tarefas que não requerem resultados imediatos e que podem ser realizadas offline.

Exemplos de processamento em batch incluem processamento de folha de pagamento, geração de relatório e backups de dados. O processamento em batch permite otimizar a utilização de recursos e é rentável para o processamento de grandes conjuntos de dados.

Tratamento em tempo real

O processamento em tempo real, ou stream processing, envolve o processamento de dados à medida que estes são recebidos por um fluxo contínuo. Esta abordagem é essencial para as aplicações que requerem respostas imediatas a eventos ou alterações nos dados.

Alguns exemplos incluem a deteção de fraudes, a análise do mercado bolsista e o processamento de dados por sensores. O tratamento em tempo real exige uma infraestrutura reativa e algoritmos especializados para gerir o fluxo contínuo de dados.

Limpeza de dados

A limpeza de dados consiste em identificar e corrigir ou remover erros, inconsistências e imprecisões do conjunto de dados.

Trata-se de um passo crucial em qualquer projeto orientado por dados, uma vez que garante a qualidade e a fiabilidade dos dados utilizados na análise e na tomada de decisões. A limpeza dos dados envolve várias tarefas, tais como o processamento de valores em falta, a correção de inconsistências, a remoção de duplicados e a normalização de formatos.

Análise de dados

A análise de dados inspeciona, limpa, transforma e modela dados para descobrir informações úteis, informar conclusões e apoiar a tomada de decisões. Existem diferentes tipos de análise de dados, cada uma com um objetivo único:

Análise descritiva

A análise descritiva é a forma mais básica de análise de dados. Centra-se em resumir e descrever o que aconteceu no passado.

Este tipo de análise utiliza técnicas como a média, a mediana, o modo, e ferramentas de visualização e de desvio padrão, como gráficos para apresentar os dados de forma significativa. A análise descritiva responde à pergunta "O que aconteceu?" e ajuda a identificar tendências e padrões em dados históricos.

Diagnóstico analítico

A análise de diagnósticos vai além da análise descritiva, tentando entender por que algo aconteceu. Trata-se de aprofundar os dados, explorar relações entre variáveis e identificar as causas principais dos problemas ou sucessos. A análise de diagnóstico responde à pergunta "Por que isso aconteceu?" e ajuda a descobrir insights e dependências ocultas dentro dos dados.

Análise preditiva

A análise preditiva usa dados históricos e algoritmos estatísticos para prever resultados futuros. Identifica padrões e tendências em dados passados e extrapola-os para o futuro. A análise preditiva responde à pergunta "O que é provável que aconteça?" e é utilizada em várias aplicações, como a previsão de perda de clientes, a previsão de vendas e a avaliação de riscos.

Análise prescritiva

A análise prescritiva é a forma mais avançada de análise de dados. Ele prevê o que provavelmente irá acontecer e recomenda ações para ajudar a alcançar os resultados previstos.

Este tipo de análise utiliza técnicas de otimização e algoritmos de machine learning para sugerir a melhor ação. A análise prescritiva responde à pergunta "O que devemos fazer?" e é utilizada em áreas como a otimização da cadeia de distribuição, alocação de recursos e marketing personalizado.

Aplicações de Data Analytics em várias indústrias

A Data Analytics tornou-se um elemento chave em diferentes sectores, revolucionando as operações e os processos de tomada de decisões. Na área da saúde, é utilizada para analisar os registos de pacientes, identificar padrões que possam levar a uma deteção mais precoce de doenças, planos de tratamento personalizados e até mesmo para prever surtos.

Entretanto, no sector financeiro, a Data Analytics permite a deteção de fraudes, a avaliação de riscos, a negociação algorítmica e a análise de comportamentos dos clientes, com o objetivo de otimizar estratégias de investimento e personalizar produtos financeiros.

O sector retalhista tira partido da análise de dados para ajudar a obter informações valiosas sobre as preferências e os hábitos de compra dos consumidores. Os retalhistas podem personalizar as recomendações dos produtos, otimizar a gestão do inventário e criar campanhas de marketing orientadas, analisando os dados da transação. Os fabricantes exploram a análise de dados para melhorar a eficiência da produção, prever falhas nos equipamentos e otimizar as cadeias de abastecimento, reduzir os custos e melhorar a qualidade do produto.

Mesmo em sectores como o transporte e a logística, a análise de dados desempenha um papel fundamental na otimização de rotas, na previsão de atrasos e no aumento da eficiência do combustível. No sector da energia, contribui para a monitorização dos padrões de consumo de energia, para a previsão das flutuações da procura e para a otimização da distribuição dos recursos.

Quais são as diferentes competências em Data Analytics?

Processamento de Linguagem Natural

As habilidades de PLN (Processamento de Linguagem Natural) aprofundam-se no intrincado mundo da linguagem humana, permitindo que máquinas ajudem a entender, interpretar e gerar texto que espelhe a comunicação humana.

Esta poderosa técnica encontra aplicações na análise de sentimentos, onde mede emoções e opiniões expressas em texto; tradução de linguagem, que quebra barreiras linguísticas e facilita a comunicação global; e desenvolvimento chatbot, que cria assistentes virtuais capazes de se envolverem em conversas naturais.

Identificação de Anomalias por Análise Anómala

Competências de análise de valores atípicos são fundamentais na identificação de pontos de dados que se desviam significativamente da norma. Estas anomalias podem indicar erros na introdução de dados, atividades fraudulentas ou eventos raros com implicações significativas. Detetando valores atípicos, podemos desencadear intervenções atempadas, investigar potenciais problemas e assegurar a qualidade dos dados.

Análise de Coortes: Segmentação de dados para maior clareza

A análise de coortes consiste em segmentar dados em grupos distintos com base em características ou experiências compartilhadas. Esta técnica ilumina o comportamento dos clientes, revelando padrões de hábitos de compra, taxas de rotatividade e níveis de compromisso. Ao compreender a dinâmica dos coortes, as empresas podem adaptar as suas estratégias a segmentos específicos de clientes e otimizar os seus esforços de marketing.

Desbloquear Informações com Extração de Texto

Estão intimamente relacionadas as habilidades de mineração de texto, que envolve a extração de padrões significativos e informações de dados de texto não estruturado. Estas competências revelam-se inestimáveis para tarefas como a modelização de tópicos, na qual são descobertos temas escondidos em grandes volumes de texto; a classificação de documentos, a organização automática e a categorização dos documentos utilizados com base no seu conteúdo; e a recuperação de informações, permitindo uma pesquisa e extração eficiente de informações relevantes de repositórios de texto.

Análise de regressão: Prever e Compreender Tendências

As competências em análise de regressão concentram-se na compreensão da relação entre as variáveis e na previsão de resultados futuros. Ao estabelecer modelos matemáticos, esta técnica permite aos analistas prever as tendências de vendas, estimar os valores das propriedades e avaliar o impacto das campanhas de marketing. A compreensão destas relações permite uma tomada de decisões baseada em dados.

Análise de cenários via simulações de Monte Carlo

As simulações de Monte Carlo utilizam uma amostragem aleatória para modelar e analisar a probabilidade de diferentes resultados em vários cenários. No sector financeiro, avaliam os riscos do investimento e avaliam o desempenho da carteira. No âmbito da gestão de projetos, estimam os prazos e os custos do projeto. Simulando a incerteza, as simulações de Monte Carlo permitem tomar decisões informadas em situações complexas.

Analisar dados do sensor para uma compreensão mais profunda

As competências em análise de dados de sensores destravam o conhecimento através da análise de dados recolhidos a partir de vários sensores. No domínio da saúde, contribui para a vigilância e a deteção de doenças. Na indústria transformadora, otimiza os processos de produção e prevê falhas nos equipamentos.

No monitoramento ambiental, essas habilidades rastreiam os níveis de poluição e os padrões climáticos. Ao analisar os dados dos sensores, obtemos informações mais aprofundadas sobre o mundo à nossa volta e tomamos decisões informadas.

Desvendar Dados Complexos com Análise de Fatores

As competências em análise fatorial examinam a estrutura subjacente a dados complexos, identificando variáveis latentes ou fatores que explicam as correlações observadas entre variáveis. Na pesquisa de mercado, a análise de fatores ajuda a identificar as preferências do consumidor e segmentar os mercados. Em psicologia, ela descobre traços de personalidade e dimensões. Ao simplificar dados complexos, a análise de fatores facilita a interpretação e a compreensão.

Padrões de Desencriptação com Análise de Séries Temporais

A análise de séries temporais decifra padrões e tendências em dados coletados ao longo do tempo. Analisando as dependências temporais e as flutuações dos dados, esta técnica permite uma previsão de vendas precisa, a deteção de anomalias nos logs do sistema e a identificação de relações causais nos dados económicos. Compreender os padrões passados e presentes permite-nos prever o futuro e tomar decisões proactivas.

Ferramentas de Análise de Dados

As ferramentas de análise de dados são programas de software e aplicações que funcionam como soluções de análise de dados para ajudar a recolher, processar, analisar e visualizar grandes volumes de dados. São cruciais para transformar dados brutos em informações práticas que fomentem uma tomada de decisões informada. Estas ferramentas permitem às empresas descobrir padrões ocultos, identificar tendências e prever resultados futuros, o que resulta numa maior eficiência operacional, numa maior rentabilidade e numa vantagem competitiva no mercado.

O papel da Data Analytics na tomada de decisões empresariais

A Data Analytics é essencial para permitir que as empresas tomem decisões informadas, otimizem as operações e fomentem a inovação. Ao explorar o poder dos dados, as empresas podem obter informações valiosas sobre o comportamento dos clientes, as tendências do mercado e muito mais.

Os analistas de dados de carreira interpretam o ambiente de dados. Recolhem, processam e analisam habilmente grandes volumes de informação, transformando os dados brutos em informações exploráveis. Os analistas de carreira usam uma variedade de técnicas, desde a análise estatística à visualização de dados, para descobrir tendências, padrões e correlações que podem informar a tomada de decisões estratégicas. O seu trabalho é essencial num mundo dirigido por dados, permitindo que as organizações compreendam melhor as suas operações, clientes e mercados.

O papel do analista vai para além da confusão dos números. Os analistas são comunicadores eficazes e especialistas na tradução de descobertas complexas em relatórios e apresentações claras e concisas. Colaboram frequentemente com as partes interessadas de toda a organização, garantindo que as informações orientadas por dados não só são compreendidas, como também implementadas. Quer se trate da otimização de processos empresariais, da identificação de novas oportunidades ou da atenuação de riscos, os analistas desempenham um papel crucial na exploração de dados para garantir o sucesso.

Melhorar A Compreensão Do Cliente Através Da Análise De Dados

A Data Analytics permite que as empresas aprofundem o comportamento, as preferências e os padrões de compra dos clientes. Ao analisar os dados dos clientes, as empresas podem identificar tendências, segmentar o seu público-alvo e personalizar os seus esforços de marketing. Esta compreensão melhorada dos clientes permite-lhe oferecer produtos personalizados, um melhor serviço ao cliente e uma maior satisfação dos clientes.

Orientando o Desenvolvimento de Produtos com Informações da Data Analytics

A Data Analytics oferece informações valiosas sobre as preferências do cliente, os pontos fracos e as tendências emergentes. Ao analisar os dados de utilização dos produtos, os comentários e a pesquisa de mercado, as empresas podem identificar oportunidades de inovação e melhoria dos produtos. O desenvolvimento do produto baseado em dados garante que os novos produtos e funcionalidades se adequam às necessidades do cliente, aumentando a adoção e a fidelização do cliente.

Elaboração de estratégias de marketing eficazes com Data Analytics

As empresas podem otimizar as suas estratégias de marketing com a análise de dados, identificando os canais, as mensagens e as campanhas mais eficazes. Ao analisar os dados das campanhas de marketing, as empresas podem medir o retorno sobre o investimento (ROI) dos seus esforços e aperfeiçoar a sua abordagem. O marketing baseado em dados assegura uma alocação eficiente dos recursos e as campanhas visam o público certo, maximizando o impacto e impulsionando os resultados.

Facilitar O Dimensionamento Das Operações De Dados Através Da Análise De Dados

À medida que as empresas crescem, o mesmo acontece com o volume e a complexidade dos seus dados. A Data Analytics ajuda as empresas a escalar as suas operações de dados através da implementação de práticas eficientes de gestão de dados, da automatização do tratamento de dados e da garantia da qualidade dos dados. As operações de dados escaláveis permitem às empresas tirar o máximo valor dos seus ativos de dados e apoiar a tomada de decisões baseada em dados em toda a organização.

Aumentar a eficiência operacional através da Data Analytics

A análise de dados pode melhorar significativamente a eficiência operacional através da identificação de estrangulamentos, da otimização de processos e da melhoria da alocação de recursos. Ao analisar dados operacionais, as empresas podem identificar áreas a melhorar, otimizar os fluxos de trabalho e reduzir os custos. As ideias orientadas por dados permitem às empresas tomar decisões baseadas em dados, fomentando a excelência operacional e melhorando a produtividade global.

OVHcloud e Data Analytics

A OVHcloud oferece uma série completa de soluções de infraestrutura cloud e de data analytics para ajudar as empresas no seu percurso de dados - e todos os que estejam interessados em tornar-se analistas de dados durante as suas carreiras.

Desde recursos de computação escaláveis até plataformas de dados geridas, a OVHcloud oferece as ferramentas e a experiência necessárias para ajudar as organizações a recolher, armazenar, processar e analisar os seus dados de forma eficaz. Graças à infraestrutura fiável e segura da OVHcloud, as empresas podem concentrar-se em extrair informações valiosas dos seus dados e impulsionar a inovação baseada em dados.